Bild: Ulrich Buckenlei | XR Stager Newsroom

𝗧𝗛𝗜𝗦 𝗪𝗘𝗘𝗞 𝗜𝗡 𝗧𝗘𝗖𝗛 – Willkommen bei den Technovation Highlights in der Woche vom 9.–15. Juni 2025, präsentiert vom XR Stager Online Magazin

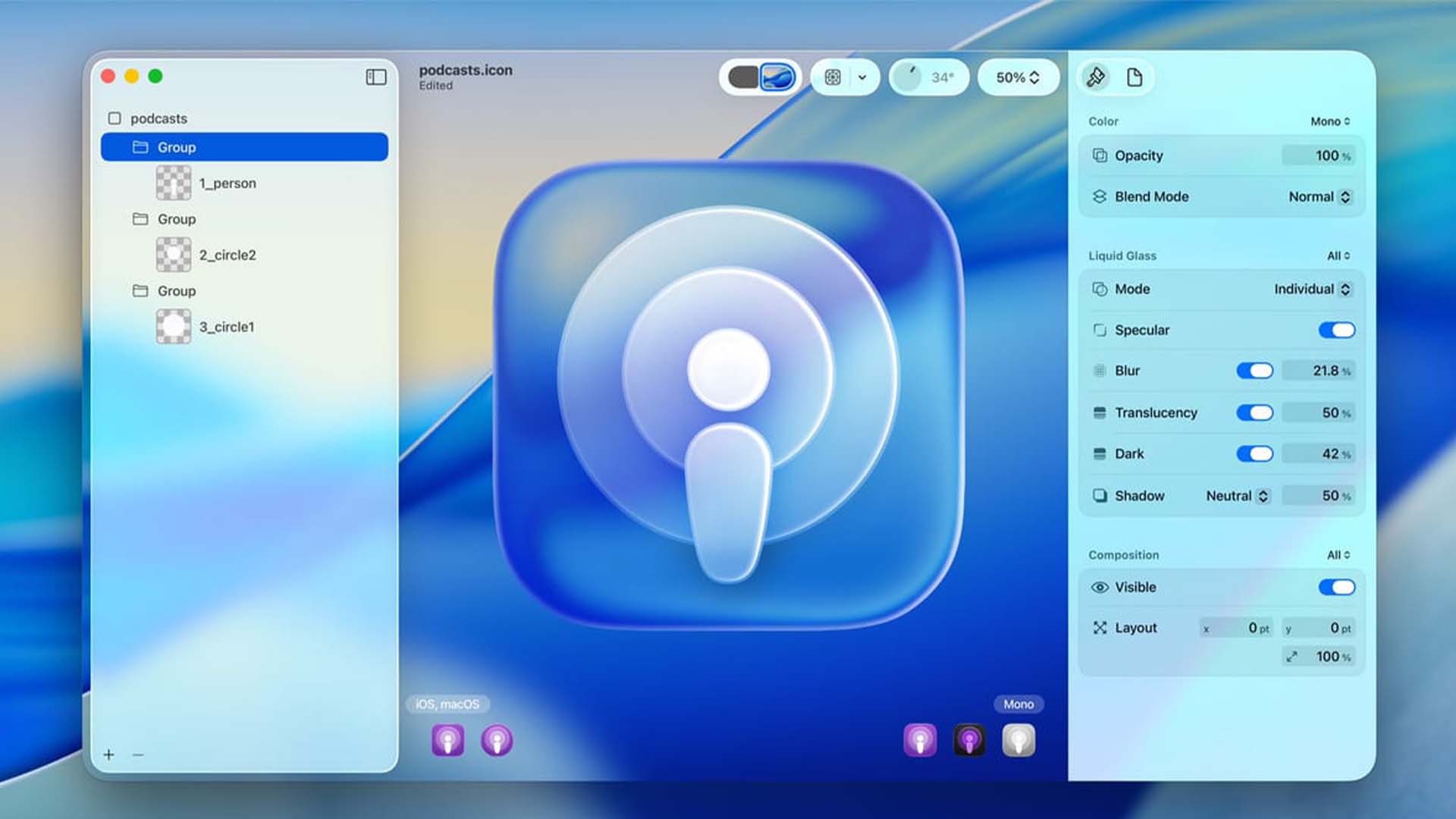

Apple WWDC 2025 – visionOS4 bringt AI-Widgets und Liquid Glass UI

Mit der WWDC 2025 hat Apple in der 24. Kalenderwoche ein neues Kapitel im Zusammenspiel von Künstlicher Intelligenz und räumlichem Computing aufgeschlagen. Im Mittelpunkt stand das neue System „Apple Intelligence“, das über iPhone, iPad und Mac hinweg personalisierte AI-Funktionen einführt – von kontextueller Textgenerierung über semantische Suche bis hin zu Bildbearbeitung per Spracheingabe. Das Besondere: Apple kombiniert dabei lokale Intelligenz mit On-Device-Sicherheit und einem starken Fokus auf Privatsphäre. Besonders aufhorchen ließ die Integration des Systems in bestehende Apps wie Mail, Notes und Pages – alles in einem konsistenten UI-Design, das typisch für Apple ist.

Auf der Hardwareseite wurde auch die Rolle des Vision Pro Headsets weiter gestärkt. Zwar blieb eine neue Version aus, doch iPad-Apps erhalten nun native Unterstützung auf visionOS, und neue APIs ermöglichen erweiterte Interaktionen mit spatialen Elementen. Gleichzeitig stellte Apple Developer Tools vor, die es erlauben, AI-Modelle direkt im Xcode mit nativen Vision-Pro-Interfaces zu verknüpfen – ein klares Signal in Richtung immersive und intelligente App-Entwicklung. Besonders für Entwickler von XR-Software ergibt sich hier eine neue strategische Chance.

Zusätzlich kündigte Apple eine enge Zusammenarbeit mit OpenAI an, um ausgewählte GPT-Funktionen nahtlos in Siri und andere Systemdienste einzubetten. Dabei bleibt Apple seiner Linie treu: Die Kontrolle über Datenverarbeitung bleibt beim User, alle AI-Funktionen sind standardmäßig optional und lokal deaktivierbar. Damit positioniert sich Apple nicht nur als Anbieter von Hardware, sondern als Plattform für verantwortungsvolle, nutzerzentrierte AI im räumlichen Kontext – mit Blick auf Datenschutz, UX und Systemintegration.

- Liquid Glass UI: Transparente, reaktive Interfaces

- AI-gestützte Systemwidgets

- Fokus auf Spatial Interactions

QUELLE: Ulrich Buckenlei (Digital Analyst)

WWDC 2025: visionOS 4 transformiert die XR-Bedienung mit AI-Widgets und neuen Oberflächen.

Bildquelle: Apple

NVIDIA JUPITER – Europas schnellster AI-Supercomputer startet

In Woche 24 markierte der offizielle Start von JUPITER – einem der ambitioniertesten KI-Supercomputerprojekte Europas – einen wichtigen Meilenstein in der internationalen Technologieentwicklung. Entwickelt vom Forschungszentrum Jülich in Zusammenarbeit mit NVIDIA, ParTec und Eviden, kombiniert das System modernste NVIDIA Grace Hopper Chips mit einer speziell abgestimmten Infrastruktur für Large Language Models (LLMs), Simulationsforschung und industrielle AI-Anwendungen.

JUPITER wird mit mehr als einem ExaFLOP Rechenleistung betrieben und ist für die Verarbeitung riesiger Datenmengen in Echtzeit ausgelegt. Damit eignet er sich nicht nur für wissenschaftliche Klimamodelle, medizinische Proteinanalysen oder Verkehrsoptimierung, sondern insbesondere für die Entwicklung europäischer Foundation Models – etwa im Bereich Medizin, Energiewende oder KI-Sicherheit. Auch Startups und mittelständische Unternehmen sollen über dedizierte Zugriffsmöglichkeiten profitieren.

Was JUPITER besonders macht, ist nicht nur seine Skalierbarkeit, sondern auch die Integration von „AI at Scale“-Strategien mit Fokus auf Nachhaltigkeit: Ein ausgeklügeltes Kühlsystem und die Nutzung erneuerbarer Energien ermöglichen eine energieeffiziente Supercomputing-Infrastruktur, die Maßstäbe setzen könnte. Für Europa ist das Projekt ein starkes Signal im globalen Wettlauf um technologische Souveränität im KI-Zeitalter – und für NVIDIA ein Beweis für seine Schlüsselrolle in der AI-Ökonomie von morgen.

- AI-Supercomputing mit über 90 ExaFLOPS

- Forschung in Medizin, Klima und Robotik

- Europäisches Spitzenprojekt für KI

QUELLE: NVIDIA NEWSROOM

JUPITER markiert Europas Einstieg in das ExaFLOP-Zeitalter der künstlichen Intelligenz.

Bildquelle: NVIDIA

Snapdragon AR1+ – AI-Brille ohne Smartphone

In der Kalenderwoche 24 sorgte Qualcomm für Aufsehen mit dem offiziellen Launch des neuen Snapdragon AR1+ Gen 1 Chips, der erstmals speziell für kompakte, autonome AI-Brillen entwickelt wurde. Im Unterschied zu bisherigen AR-Plattformen benötigt diese Lösung kein verbundenes Smartphone mehr – alle Rechenprozesse, Sensorfusionen und AI-Modelle laufen direkt auf dem Chip innerhalb des Wearables.

Der AR1+ ist für ultraleichte Brillen konzipiert, die ständig einsatzbereit sind: Ob Navigation, AI-gestützte Assistenzen, visuelle Suche oder Kontextübersetzung – die Brille erkennt, was in der Umgebung passiert, analysiert Inhalte in Echtzeit und blendet nur dann Informationen ein, wenn sie relevant sind. Die starke On-Device-KI erlaubt nicht nur eine niedrigere Latenz, sondern verbessert auch den Datenschutz, da Daten lokal verarbeitet werden.

Auch Partner wie Ray-Ban Meta, OPPO und Xiaomi sollen bereits an Produkten mit dem AR1+ arbeiten. Besonders spannend: Die Plattform ist offen für Drittentwickler, was ein neues Ökosystem rund um AI-gestützte Augmented-Reality-Erfahrungen fördern könnte. Mit dem AR1+ beginnt Qualcomm eine neue Phase – weg vom Smartphone als AR-Host, hin zu echter Spatial Intelligence direkt auf dem Kopf.

- Autonomes AR-Erlebnis mit AI-Integration

- Volle Spatial Computing Features

- Optimiert für Alltag & Interaktion

QUELLE: Qualcomm News

Die neue AR1+ bringt AI direkt aufs Auge – ohne Smartphone oder Tethering.

Bildquelle: Qualcomm

CGT Europe Summit – Die vierte industrielle Revolution startet in Paris

Mitten im Herzen von Paris wurde die nächste Phase der industriellen Transformation eingeläutet: Der CGT Europe Summit versammelte in KW 24 führende Köpfe aus Industrie, Forschung, KI und Automation, um die Weichen für eine neue Ära zu stellen – geprägt von kognitiven Fabriken, digitalen Zwillingen, Edge-AI und immersiver Mensch-Maschine-Interaktion.

Im Zentrum der Konferenz standen konkrete Projekte, bei denen AI, XR und Robotics nicht nur als Zukunftsvision diskutiert, sondern bereits in realen Produktionsumgebungen eingesetzt werden – etwa bei Renault, Schneider Electric und Bosch Rexroth. Die Kombination aus Datenintelligenz, 3D-Simulation und autonomen Steuerungen zeigt: Die europäische Industrie treibt die Transformation mit Hochdruck voran und beginnt, eigene Plattformen und Standards zu etablieren.

Ein viel diskutierter Begriff war „Cognitive Green Twin“ – ein neuer Ansatz, bei dem Energieeffizienz, Nachhaltigkeit und Echtzeitoptimierung im Zentrum smarter Produktionssysteme stehen. Der Summit unterstrich einmal mehr: Die vierte industrielle Revolution hat begonnen – nicht in ferner Zukunft, sondern jetzt – mit Europa als Impulsgeber.

- Globales Bekenntnis zur industriellen Transformation

- AI, Robotics, XR im Fokus

- Paris als europäisches Zentrum der Tech-Zukunft

QUELLE: Ulrich Buckenlei (Digital Analyst)

Von Paris in die Welt: Die vierte industrielle Revolution nimmt Fahrt auf.

Bildquelle: CGT Europe

Niantic Spatial @ AWE USA

Auf der AWE USA präsentierte Niantic ein visionäres Projekt, das die Verschmelzung von Geodaten, AR und sozialen Netzwerken neu denkt: Niantic Spatial verknüpft reale Orte mit augmentierten Informationen – angereichert durch Instagram-Daten, visuelle Marker und KI-generierte Interaktionen. Das Ergebnis: Eine spielerische, tiefere Wahrnehmung der physischen Welt – geprägt von Kontext, Kreativität und Community.

Das System nutzt Geo-AI, um Inhalte abhängig vom Aufenthaltsort, der Tageszeit oder dem sozialen Bezug zu generieren. In der Demo konnten Besuchende durch reale Städte navigieren, Hinweise sammeln, Inhalte freischalten und dabei auf Freunde oder kollektive Challenges treffen. Die Grenzen zwischen Spiel, Social App und Navigation verschwimmen vollständig.

Was hier entsteht, ist mehr als nur „Pokémon Go 2.0“: Es ist der Entwurf einer neuen Realitätsebene, in der öffentliche Räume zum personalisierten, interaktiven Erlebnisraum werden. Niantic gibt damit einen Vorgeschmack auf die zukünftige Rolle von AR im urbanen Alltag – lokal, sozial, dynamisch.

- Geo-AI trifft auf soziale Netzwerke

- Augmentierung realer Orte via Instagram-Daten

- Gamifizierte Navigation durch echte Städte

QUELLE: awexr.com

Niantic zeigt neue AR-Demo auf Basis von Instagram und Geo-AI.

Bildquelle: Niantic Labs

ElevenLabs Eleven V3 Alpha

In Kalenderwoche 24 sorgte ElevenLabs mit der Veröffentlichung von Eleven V3 für Aufmerksamkeit – dem bislang leistungsstärksten Multilingual Voice-Modell des Unternehmens. Die neue Version erlaubt nicht nur deutlich realistischere Stimmen in über 30 Sprachen, sondern unterstützt auch dynamische Ausdrucksformen wie Emotion, Betonung und Pausen – ein echter Fortschritt im Vergleich zu den vorherigen Modellen. Besonders in den Bereichen Storytelling, Filmproduktion, Lernplattformen und Games kommt das Update gut an, da es auch personalisierte Stimmdesigns unterstützt.

Im Zentrum des Updates stehen zwei Features: erstens die Fähigkeit, auch komplexe Emotionen wie Ironie, Nervosität oder Begeisterung glaubwürdig hörbar zu machen – zweitens eine neue API, mit der Entwickler per Code präzise Stimmanpassungen vornehmen können. Die Reaktionen aus der Creator-Community zeigen: Viele sehen darin nicht nur ein Tool für Content-Produktion, sondern eine neue Ebene der Mensch-Maschine-Interaktion – gerade für barrierefreie Anwendungen und KI-gestützte Avatare.

Auch im Vergleich zu Konkurrenzprodukten wie Play.ht oder Microsoft Azure Voice positioniert sich Eleven V3 durch Natürlichkeit, Schnelligkeit und Anpassbarkeit weit vorne. Besonders hervorzuheben: Die Stimmen klingen jetzt nicht mehr generisch, sondern tragen auf Wunsch klare Persönlichkeitsmerkmale – ob sachlich, kreativ oder theatralisch. Damit ist ElevenLabs aktuell einer der zentralen Taktgeber im boomenden Feld der generativen Sprach-KI.

- Emotion-Responsive Text-to-Speech (TTS)

- Multilingual & realistisch

- Für Games, Bildung, AI-Agents

QUELLE: ElevenLabs Blog

Neue TTS-Stimmen reagieren auf Emotionen in Echtzeit.

Bildquelle: ElevenLabs

Google Veo 3 – Speed Boost Update

Google hat mit Veo 3 ein imposantes Upgrade seines KI-gestützten Video-Generators präsentiert. Das neue Modell bringt nicht nur mehr visuelle Qualität, sondern vor allem Tempo: Die Generierung von Videosequenzen erfolgt deutlich schneller, flüssiger und konsistenter. Besonders bei längeren Clips oder komplexeren Szenen zeigt sich die neue Power – Prompt-to-Video in einer Qualität, die kreativen Output beschleunigt wie nie zuvor.

Neben der verbesserten Geschwindigkeit liefert Veo 3 erstmals eine dynamische Szenenführung, bei der Kameraeinstellungen, Perspektivenwechsel und Bildtiefe realistisch nachempfunden werden. Die Integration von Bewegungslogik, Umgebungsdetails und narrativen Spannungsbögen ist ein Quantensprung gegenüber früheren Versionen.

Google plant, Veo nicht nur für die Forschung, sondern auch für YouTube Shorts und Creator-Plattformen bereitzustellen. Damit wird aus einem Prototyp ein Massentool für kreative KI-Produktion – mit großem Potenzial für Werbeclips, Content Creation, Bildungsfilme und Storytelling in der Medienlandschaft von morgen.

- Schnelleres Video-Rendering aus Text

- Neue Kontrollfeatures wie Perspektivenswitch

- Stärkere KI für flüssige Bewegungen

QUELLE: Google Blog

Google Veo 3 bringt Tempo und Kontrolle ins KI-Video.

Bildquelle: Google

EU XM-Master – XR-Robotics für die Industrie 5.0

Mit dem Projekt EU XM-Master rückt Europa die Verbindung von Extended Reality (XR) und Robotiktraining in den Mittelpunkt seiner Industrieoffensive. Ziel ist es, die Qualifizierung für hochkomplexe Produktionssysteme neu zu denken – und zwar dort, wo klassische Schulung an ihre Grenzen stößt: bei Echtzeit-Daten, räumlichem Denken und physischer Interaktion.

Das Training erfolgt in immersiven Simulationsumgebungen, die reale Industrieanlagen präzise abbilden. Die Lernenden steuern Roboterarme, Maschinen und Wartungssysteme mit natürlichen Handbewegungen, analysieren KI-gestützte Sensordaten in Mixed-Reality-Overlays und lernen durch Trial & Error – ohne Risiko, ohne Materialverbrauch, mit maximalem Lerneffekt.

Hinter dem Projekt stehen namhafte Partner wie Fraunhofer, CEA und TNO, unterstützt von der Europäischen Kommission. Der Fokus liegt auf nachhaltiger Transformation, inklusiver Ausbildung und produktionsnaher Forschung. XM-Master ist damit ein Leuchtturm für die Industrie 5.0 – dort, wo menschzentrierte KI, Automatisierung und XR-Training verschmelzen.

- Trainingsplattform mit XR & realen Robotiksystemen

- Frühe Prototypen für Industrie 5.0

- Unterstützt auch KI-Co-Agents & digitale Zwillinge

QUELLE: CORDIS.europa.eu

EU fördert XR-gestützte Robotikschulungen für Industrieumgebungen.

Bildquelle: EU Projektplattform

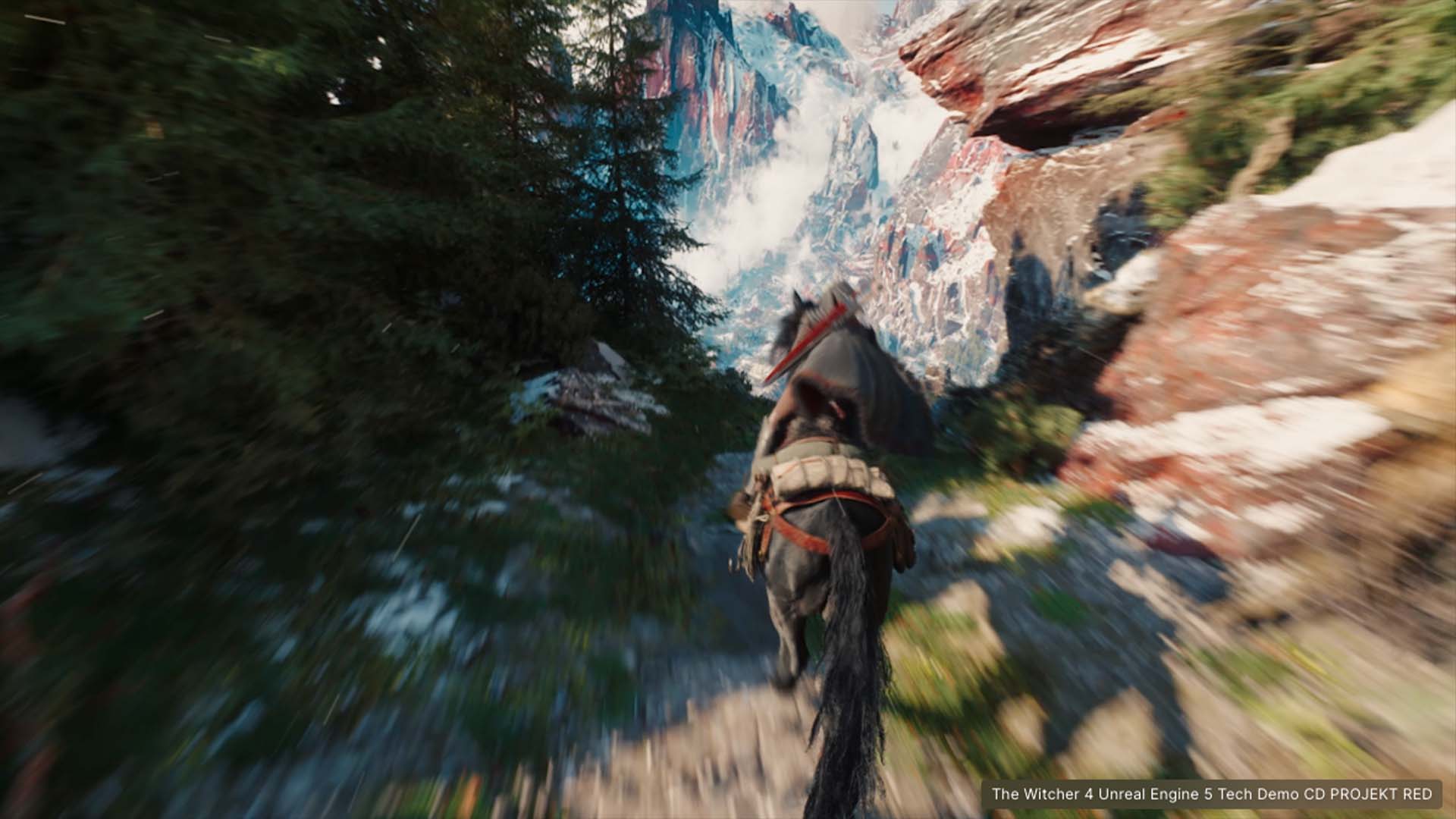

Unreal Engine 5.6 Bigger Worlds, Faster Renders

Mit dem Release von Unreal Engine 5.6 hebt Epic Games seine Realtime-Engine auf ein neues Level – und bringt gleichzeitig Film, Game und Industrieproduktion näher zusammen. Die neue Version überzeugt vor allem durch zwei Verbesserungen: größere Welten und deutlich schnellere Renderzeiten.

Im Zentrum stehen Technologien wie World Partition Streaming, das riesige 3D-Umgebungen flüssig in Sektionen lädt, und der überarbeitete Nanite Geometry System, der Milliarden von Polygonen in Echtzeit darstellt – jetzt auch mit dynamischer Geometrie und Materialwechsel. Kombiniert mit Lumen Global Illumination, erreicht UE 5.6 eine neue Qualität bei Licht, Tiefe und physikalischer Realität.

Für Developer, Architekten und Filmemacher heißt das: Noch realistischere Szenen, kürzere Produktionszeiten und erstmals auch echte simulierte Physik für Vegetation und Crowd-Verhalten. Unreal 5.6 wird damit zur zentralen Plattform für immersive Content Creation – von der Smart Factory bis zum Virtual Set.

- MetaHuman-Update & realistisches Facial Rigging

- Level-Streaming für riesige Spielwelten

- Neue Tools für Echtzeit-Animation & Design

QUELLE: Unreal Engine Blog

Unreal Engine 5.6 mit MetaHuman-Boost in Witcher 4 Demo.

Bildquelle: Epic Games

BONUS – Jugendstudie: XR wird zur Leittechnologie

Eine neue Jugendstudie aus Deutschland zeigt: XR ist für die Gen Z längst keine Spielerei mehr, sondern wird zunehmend als zentrale Zukunftstechnologie wahrgenommen. Über 70 % der Befragten zwischen 14 und 24 Jahren gaben an, dass sie sich vorstellen können, in Zukunft XR-Anwendungen im Alltag, in Bildung oder im Beruf regelmäßig zu nutzen.

Besonders auffällig: Während klassische Social-Media-Plattformen wie Instagram und TikTok weiter genutzt werden, wächst das Interesse an immersiven Räumen, in denen Avatare, KI und Interaktion verschmelzen. XR wird in der Studie explizit als „relevanter als klassische Computerinterfaces“ bezeichnet – mit Potenzial für Kommunikation, Shopping, Kreativität und Lernen.

Die Studie, durchgeführt von einem interdisziplinären Team aus Bildungsforschung und Medienpädagogik, empfiehlt, XR-Kompetenz bereits in der Schule zu fördern. XR wird damit nicht nur zur Leittechnologie einer neuen Tech-Generation, sondern auch zu einem gesellschaftlichen Bildungsauftrag.

- 63 % der Jugendlichen setzen auf immersive Technologien

- XR & AI führen vor Gaming und Social Media

- Technikvisionen beeinflussen Berufswahl & Studienwünsche

QUELLE: XRA.ORG

63 % der Jugendlichen zeigen starkes Interesse an immersiver Technologie.

Bildquelle: EDU Insights

Jetzt die Chancen nutzen!

Das Visoric-Team unterstützt Unternehmen bei der Einführung innovativer Technologien – von immersiven Echtzeitanwendungen bis zu KI-gestützten Assistenzsystemen.

Unsere Leistungen umfassen:

- Strategieberatung und Technologietransfer → Potenziale von XR, KI und Digital Twins konkret zu nutzen.

- Individuelle Lösungsentwicklung → Von Prototypen bis hin zu produktiven Systemen.

- Schulungen und Enablement → Wir machen Ihre Teams fit für die nächste Technologiegeneration.

Lassen Sie uns gemeinsam starten – kontaktieren Sie das Visoric-Team noch heute und gestalten Sie den Wandel aktiv mit!

Kontaktieren Sie uns:

E-Mail: info@xrstager.com

Telefon: +49 89 21552678

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@xrstager.com

Nataliya Daniltseva (Projektleiterin)

Mobil: +49 176 72805705

E-Mail: nataliya.daniltseva@xrstager.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München