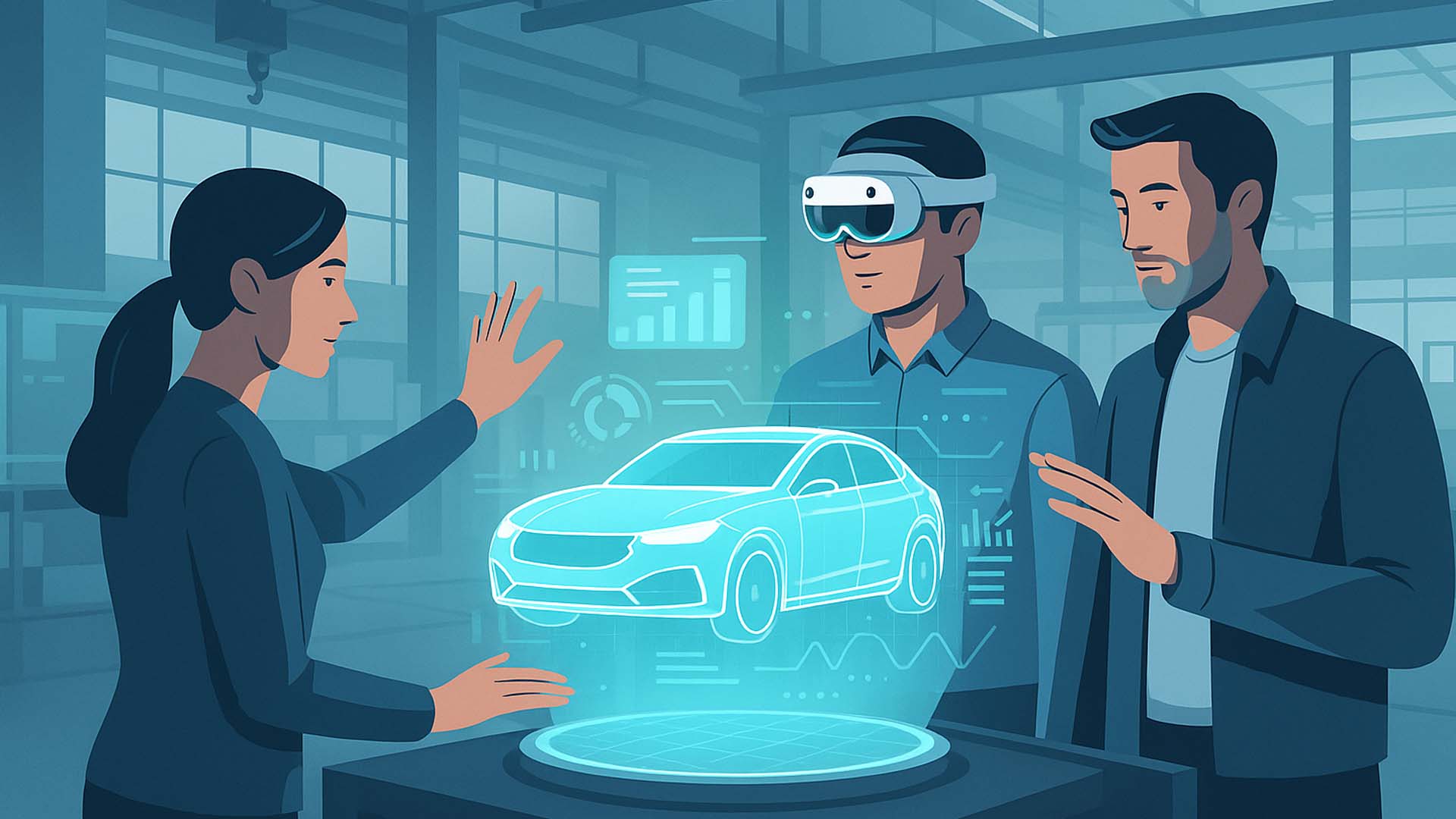

Bild: Von der Freizeit zur Fertigung – Technologien aus dem Gaming verändern Arbeitsprozesse. Visualisierung: Visoric GmbH 2025

Vom Spiel in die Arbeitswelt

Technologien, die im Wohnzimmer für Spannung sorgen, verändern heute messbar die Arbeitswelt. Bewegungspads, VR-Headsets, Hand- und Körpertracking sowie räumliche Audio- und Lichtführung verlassen die Sphäre der Spielekonsolen und werden zu Werkzeugen für Fertigung, Training und Service. Der Schlüssel liegt nicht in der Unterhaltung, sondern in der Präzision: Was in Games zuverlässig Bewegungen erfasst, Szenen in Echtzeit aufbaut und Feedback millisekundengenau liefert, eignet sich hervorragend, um reale Handgriffe gefahrlos zu üben, komplexe Abläufe zu verstehen und Teamarbeit über Entfernungen hinweg zu koordinieren.

Für Unternehmen entsteht dadurch ein neuer Lern- und Arbeitsmodus. Mitarbeitende erleben Prozesse nicht mehr als abstrakte Diagramme oder lange Handbücher, sondern als begehbare, reagierende Umgebungen. Statt „richtig“ auswendig zu lernen, entsteht Können durch Handlung: sehen, greifen, korrigieren, wiederholen. Die gleiche Sensorik, die im Spiel Belohnungen auslöst, erkennt in Trainingsumgebungen Fehler, gibt Hilfestellungen und dokumentiert Fortschritte.

Dieser Transfer gelingt, weil Gaming-Hardware für robuste, wiederholbare und latenzarme Interaktion optimiert ist. Engines, die in der Unterhaltung Milliarden Pixel zuverlässig rendern, visualisieren in der Industrie Datenströme, Sicherheitszonen oder Qualitätskennzahlen. Gleichzeitig macht räumliches Audio Situationen intuitiver: Warnungen kommen akustisch aus der Richtung, aus der eine Gefahr droht. Das senkt die kognitive Last und erhöht die Trainingswirksamkeit.

- Bewegung wird zur Information: Laufen, Greifen und Zeigen steuern Training und Prüfung

- Echtzeit-Feedback ersetzt Trial-and-Error in der Produktion durch sicheres Üben im Digitalen

- Räumliche Visualisierung macht Abläufe, Risiken und Qualität unmittelbar begreifbar

Bild: Vom Spiel zur Industrie – Technologien aus dem Gaming werden zum Werkzeug für Training, Service und Fertigung. Visualisierung: Visoric GmbH 2025

Die Konsequenz: Unternehmen verkürzen Anlernzeiten, standardisieren Qualität und können seltene, kritische Situationen gefahrlos simulieren. Statt reale Anlagen zu blockieren, laufen Szenarien parallel in virtuellen Zwillingen. Teams lernen, Fehler früh zu erkennen, Prozesse sauber zu übergeben und im Takt mit Maschinen zu arbeiten. Dieser Schritt ist kein Ersatz der Realität, sondern eine Vorbereitung darauf – so präzise, dass der Übergang in den Alltag leicht fällt.

Genau hier setzt der weitere Artikel an: Im nächsten Kapitel zeigen wir, wie Bewegung zur Steuerung wird – und warum sich natürliches Handeln besser einprägt als das Bedienen von Tasten und Menüs.

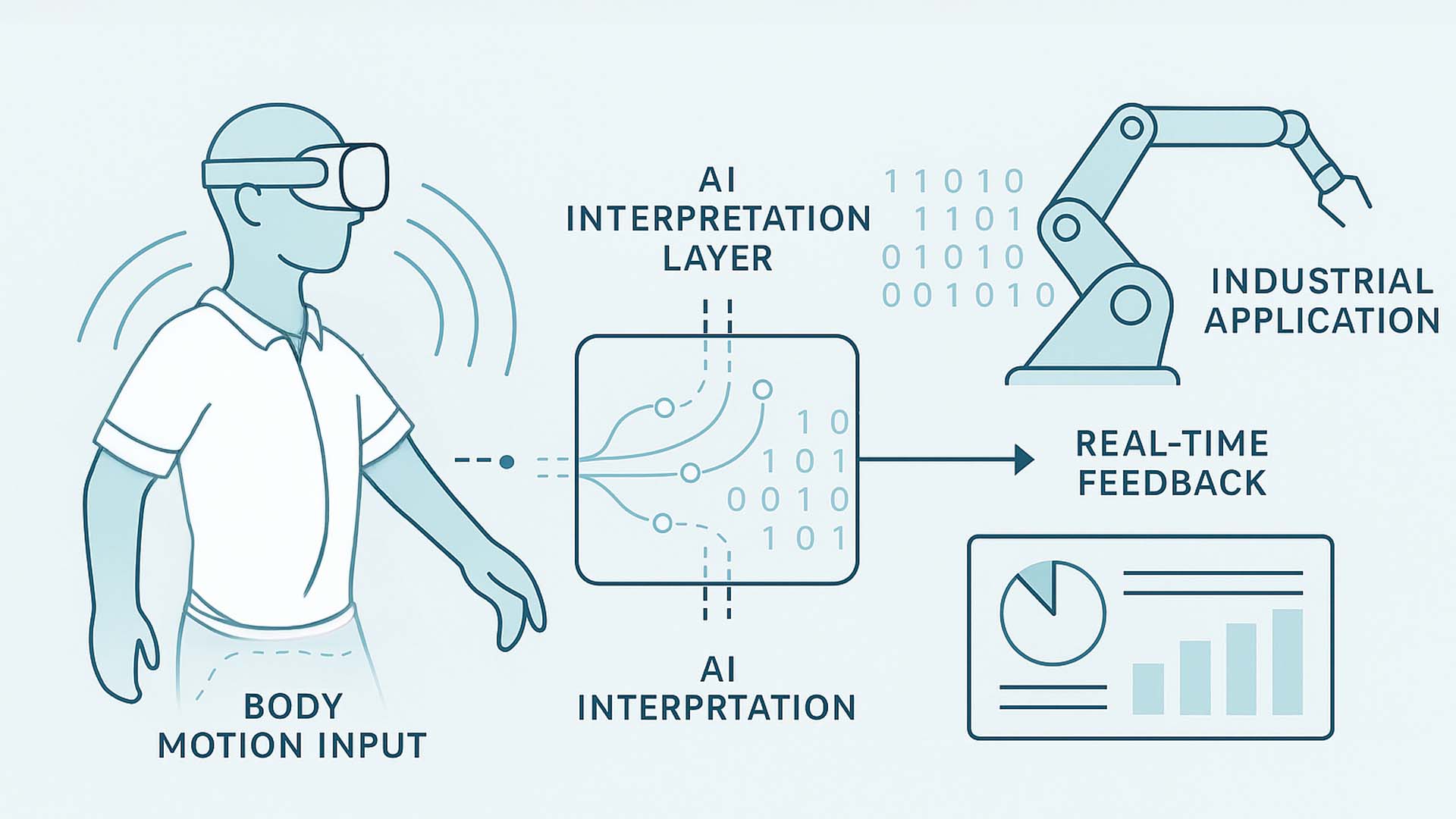

Wenn Bewegung zur Steuerung wird

Unsere Bewegungen werden zur Sprache der Maschinen. Was früher über Schalter, Touchscreens oder Controller lief, geschieht heute intuitiv durch Körperhaltung, Gesten und Position im Raum. Systeme erkennen Richtung, Geschwindigkeit und Absicht, um daraus Befehle abzuleiten. So wird das eigene Tun zur natürlichen Schnittstelle – präziser als jede Taste, weil sie direkt das Ziel beschreibt.

In modernen Arbeitsumgebungen wird diese Logik längst erprobt. Technikerinnen bedienen Roboter durch Armbewegungen, Lagerarbeiter navigieren autonome Fahrzeuge mit einfachen Gesten, und im Schulungslabor wird die Maschinensteuerung auf einem Bewegungspad simuliert, das jeden Schritt digital abbildet. Der Mensch bleibt in der Kontrolle, doch die Technik versteht ihn besser, als er selbst glaubt. Bewegung wird zum Input, Präsenz zum Signal.

Diese Entwicklung verändert nicht nur die Bedienung, sondern die gesamte Ergonomie der Arbeit. Systeme passen sich an die Nutzerin an – nicht umgekehrt. Eine falsche Haltung oder ein unsicherer Ablauf werden erkannt, bevor daraus Fehler entstehen. KI gleicht Bewegungsmuster mit optimalen Sequenzen ab und gibt präventiv Rückmeldung. Damit wird die Maschine nicht nur Werkzeug, sondern Partner.

- Gesten, Blickrichtung und Haltung ersetzen klassische Eingabegeräte

- Adaptive Systeme erkennen Intentionen und reagieren kontextsensitiv

- Bewegung wird zur universellen Sprache zwischen Mensch und Maschine

Bild: Körperbewegung als Steuersignal – Maschinen reagieren auf Intention statt auf Knopfdruck. Visualisierung: Visoric Research 2025

Die Forschung zeigt, dass Menschen mit bewegungsbasierten Interfaces bis zu 40 Prozent schneller lernen und sich Handlungsabläufe nachhaltiger merken. Der Grund: Motorik, Wahrnehmung und Kognition greifen enger ineinander. Im Gegensatz zu abstrakten Menüs wird hier physische Handlung zur direkten Erfahrung. Dadurch entsteht eine neue Qualität von Kontrolle – eine, die nicht über Technik definiert ist, sondern über menschliche Natürlichkeit.

Diese Erkenntnis prägt die nächste Entwicklungsstufe: Lernen durch Erleben. Anstatt Prozesse zu erklären, lässt man sie spürbar werden. Wie das in der Praxis aussieht, zeigt das folgende Kapitel.

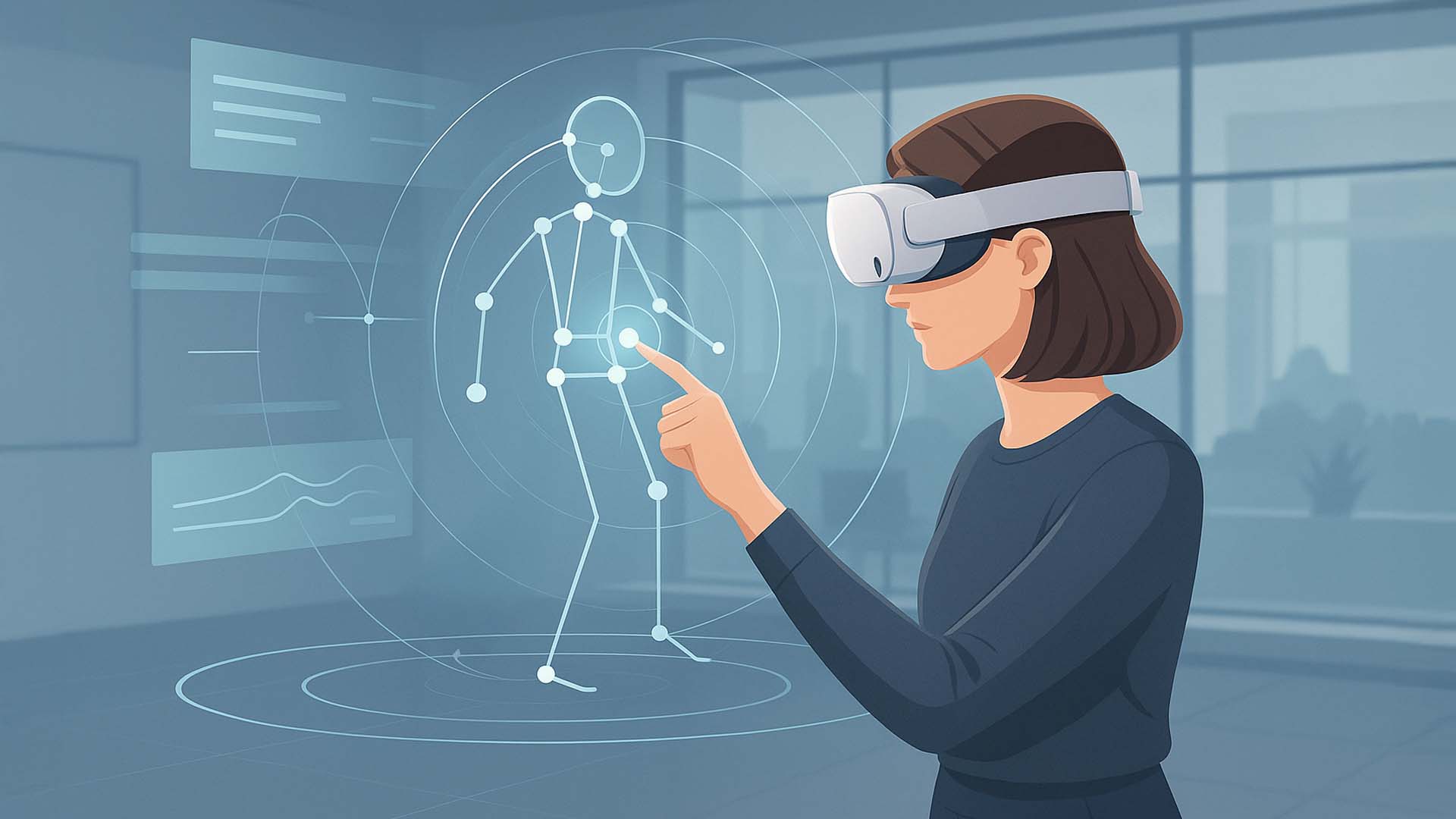

Lernen durch Erleben

Wissen bleibt nicht im Kopf, wenn es nur gelesen wird – es bleibt, wenn es erlebt wird. Diese Erkenntnis aus der Lernpsychologie bildet die Grundlage einer neuen Generation von Trainingssystemen, die auf immersive Technologien setzen. Mit Bewegungspads, Headsets und Sensorik lassen sich komplexe Arbeitsabläufe heute realitätsnah simulieren, ohne dass Maschinen, Material oder Sicherheit gefährdet werden. Der Lernende steht mitten im Prozess, sieht Ursachen und Folgen und begreift Zusammenhänge, die auf Papier abstrakt geblieben wären.

Unternehmen nutzen diese Form des Lernens, um Fachwissen schneller und nachhaltiger zu vermitteln. Statt PowerPoint und Handbuch steht das Erleben im Mittelpunkt. Fehler dürfen gemacht werden, weil sie keine Konsequenzen haben – und genau dadurch entsteht Kompetenz. Wer eine Wartung virtuell durchführt oder einen Montageprozess im digitalen Zwilling trainiert, versteht Abläufe im Detail, bevor er sie in der Realität ausführt.

Die Verbindung aus Bewegung, Echtzeitfeedback und KI-Analyse steigert nachweislich den Lernerfolg. Systeme erkennen Unsicherheiten, bieten Hilfestellungen und messen Fortschritte. Aus abstraktem Wissen wird Erfahrung, aus Erfahrung wird Können. Gleichzeitig sinken Kosten und Risiken, weil Schulungen nicht mehr an reale Maschinen gebunden sind.

- Virtuelles Training ersetzt trockene Theorie durch erlebbare Praxis

- Fehler werden analysiert, nicht bestraft – Lernen geschieht durch Handlung

- Immersive Simulationen erhöhen Sicherheit, Qualität und Motivation

Bild: Virtuelles Training mit realem Nutzen – Simulation ersetzt Theorie durch Erfahrung. Konzeptvisualisierung: Visoric XR Lab 2025

Was früher aufwändige Präsenzschulungen erforderte, kann heute flexibel und skalierbar in XR-Umgebungen stattfinden. Ob Maschinenbedienung, Sicherheitsunterweisung oder Serviceeinsatz – Lernende tauchen in Szenarien ein, die sich an ihr Können anpassen und individuelles Feedback geben.

Im nächsten Kapitel geht es darum, wie diese Erlebnisse mit realen Daten verbunden werden und wie sich Informationen dort zeigen, wo sie gebraucht werden – im Raum selbst.

Daten im Raum verstehen

Was früher Zahlen auf Monitoren waren, wird heute Teil des Raums. Mit Spatial Computing, KI und modernen 3D-Engines lassen sich Produktionsdaten, Energieflüsse oder Sicherheitsinformationen dorthin bringen, wo sie entstehen – in den physischen Arbeitsbereich. So entsteht eine neue Form der Wahrnehmung: Daten werden sichtbar, greifbar und intuitiv erfassbar.

In der Praxis bedeutet das, dass Sensorwerte, Maschinenzustände oder Prozessfortschritte als räumliche Overlays eingeblendet werden. Statt abstrakte Dashboards zu lesen, sehen Mitarbeitende direkt an der Anlage, welche Komponenten gewartet werden müssen oder wo eine Abweichung auftritt. Das verringert Suchzeiten, senkt Fehlerquoten und fördert ein gemeinsames Verständnis zwischen Technik, Planung und Ausführung.

Der Schlüssel liegt in der Verbindung von Echtzeitdaten und räumlicher Kontextintelligenz. Systeme interpretieren Position, Blickrichtung und Bewegungen der Nutzerin, um Informationen dort anzuzeigen, wo sie relevant sind. Gleichzeitig kann KI Datenmuster erkennen und Handlungsempfehlungen generieren – etwa Warnungen vor Überhitzung, Hinweise auf Qualitätsabweichungen oder Vorschläge zur Prozessoptimierung. So wird aus abstrakter Analyse eine unmittelbare, visuelle Erfahrung.

- Sensor- und Maschinendaten werden direkt im Arbeitsumfeld sichtbar

- Räumliche Overlays machen Fortschritt, Risiko und Qualität intuitiv erfahrbar

- KI erkennt Muster und zeigt Handlungsempfehlungen in Echtzeit

Bild: Reale Daten sichtbar gemacht – Spatial Computing verbindet Information und Bewegung. Visualisierung: Visoric GmbH 2025

Diese Form der Visualisierung verändert nicht nur die Bedienung, sondern auch die Kommunikation. Teams sehen denselben Datenkontext, egal ob sie vor Ort oder virtuell zugeschaltet sind. Entscheidungen werden schneller, weil Informationen räumlich verankert und damit verständlicher sind. So entsteht Transparenz – und aus Transparenz entsteht Vertrauen.

Im nächsten Kapitel geht es um den menschlichen Faktor dieser Transformation: wie virtuelle Räume zur neuen Plattform für Zusammenarbeit werden und wie Mixed Reality Meetings und Projekte verändert.

Zusammenarbeit im virtuellen Raum

Arbeit findet längst nicht mehr an einem Ort statt. Teams sind verteilt, Projekte laufen global, und doch müssen Menschen gemeinsam an denselben Modellen, Prozessen und Ideen arbeiten. Virtuelle und gemischte Realitäten schaffen dafür neue Räume: Orte, die greifbar wirken, obwohl sie digital sind. Hier können Ingenieure, Designerinnen oder Servicetechniker gemeinsam interagieren – nicht über Maus und Tastatur, sondern mitten im dreidimensionalen Geschehen.

Mixed-Reality-Meetings sind kein Ersatz für reale Begegnungen, sondern deren logische Erweiterung. Wer ein Modell in Originalgröße sieht und gemeinsam mit anderen bearbeiten kann, erlebt Zusammenarbeit auf einer neuen Ebene. Gesten werden zu Werkzeugen, Präsenz zu Kommunikation. Statt sich gegenseitig zu erklären, was gemeint ist, greifen alle buchstäblich ins gleiche Objekt. Das schafft Verständnis, beschleunigt Abstimmung und stärkt die gemeinsame Verantwortung für das Ergebnis.

Diese Technologie verändert auch das Verhältnis zwischen Mensch und Maschine. KI-basierte Avatare und Assistenzsysteme sind nicht mehr bloß Zuschauer, sondern aktive Teammitglieder. Sie protokollieren Änderungen, schlagen Lösungen vor oder visualisieren Alternativen in Echtzeit. Die Grenze zwischen physischem und digitalem Arbeitsplatz verschwimmt – und mit ihr die Grenzen der Kreativität.

- Virtuelle Räume verbinden Teams über Standorte, Sprachen und Zeitzonen hinweg

- 3D-Modelle werden gemeinsam bearbeitet, geprüft und verstanden

- KI-Assistenten unterstützen Kommunikation, Planung und Dokumentation

Bild: Teamarbeit ohne Grenzen – Mixed Reality verbindet Menschen über Standorte hinweg. Visualisierung: Visoric Collab Studio 2025

So entstehen Arbeitswelten, in denen Nähe nicht an Entfernung gebunden ist. Ideen lassen sich schneller prüfen, Änderungen gemeinsam erleben, Entscheidungen mit mehr Sicherheit treffen. Gleichzeitig wächst das Gefühl, Teil eines gemeinsamen Raums zu sein – auch wenn die Beteiligten tausende Kilometer voneinander entfernt sind.

Im nächsten Kapitel wird diese neue Form der Erfahrung messbar. Wir zeigen, wie KI und Sensorik Bewegungen auswerten, Muster erkennen und daraus Erkenntnisse für Sicherheit, Effizienz und Lernen gewinnen.

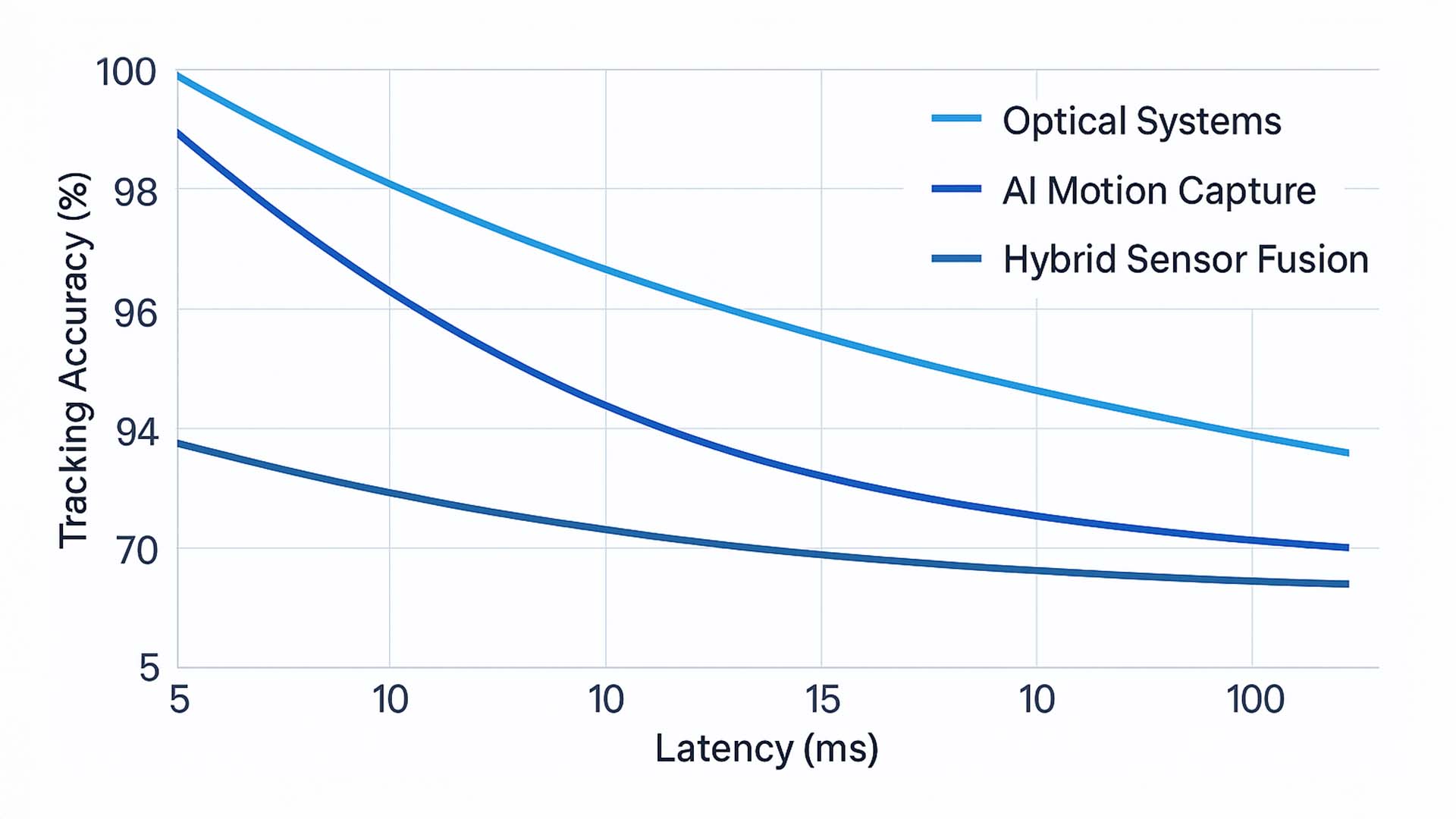

Wissenschaftliche Erkenntnisse zur Bewegungserfassung

Die Grundlage für die neuen Bewegungssysteme, die ihren Ursprung im Gaming-Bereich haben, bilden präzise Messungen menschlicher Bewegungen in Echtzeit. Ob in der Fertigung, im Training oder in der kollaborativen Robotik – die Qualität solcher Systeme hängt von zwei Faktoren ab: Genauigkeit und Latenz. Je geringer die Latenz, desto unmittelbarer reagiert das System auf eine Bewegung, und je höher die Genauigkeit, desto realistischer die Interaktion.

- Verbindung von optischen, sensorischen und KI-gestützten Verfahren

- Simulation von Bewegungsabläufen mit millisekundengenauer Reaktionszeit

- Einsatz in Schulung, Fertigung und Ergonomieoptimierung

Um diese Zusammenhänge zu veranschaulichen, zeigt die folgende Grafik den Zusammenhang zwischen Latenz und Genauigkeit verschiedener Motion-Tracking-Systeme. Besonders die sogenannten Hybrid Sensor Fusion Systeme – eine Kombination aus optischen und KI-gestützten Verfahren – erreichen das beste Verhältnis aus Reaktionszeit und Präzision.

Diagramm 1: Echtzeit-Genauigkeit im Vergleich zur Latenz verschiedener Bewegungserfassungssysteme.

Quelle: MIT CSAIL (2024), IEEE TVCG (2022), Meta Reality Labs (2023), Siemens Digital Industries (2024), Unity Research Labs (2023)

Die Ergebnisse verdeutlichen, dass rein optische Systeme zwar hohe Präzision bieten, jedoch bei schnellen Bewegungen und komplexen Szenarien eine höhere Verzögerung aufweisen. KI-basierte Verfahren reagieren schneller, sind aber auf große Datenmengen angewiesen. Der effektivste Ansatz ist die Kombination beider Welten – KI, die Sensordaten intelligent auswertet, und optische Systeme, die hochauflösende Details liefern.

Im zweiten Teil der Analyse wird gezeigt, wie verschiedene KI-Modelle Bewegungsmuster erkennen und klassifizieren. Drei Modelltypen werden verglichen: klassische Convolutional Neural Networks (CNNs), moderne Transformer-Modelle und fortgeschrittene Hybrid-AI-Systeme. CNNs erkennen lokale Muster in Bildern, Transformer verstehen zusätzlich zeitliche Zusammenhänge über längere Bewegungssequenzen hinweg, und Hybrid-Modelle kombinieren visuelle Daten mit Sensordaten aus Bewegungspads oder Kameras.

Diagramm 2: Erkennungsgenauigkeit verschiedener KI-Modelltypen bei der Bewegungsanalyse.

Quelle: MIT CSAIL (2024), IEEE TVCG (2022), Meta Reality Labs (2023), Siemens Digital Industries (2024)

Die Auswertung zeigt, dass Hybrid-Modelle mit einer Erkennungsrate von rund 94 Prozent die höchste Präzision erzielen. Sie nutzen die Stärken von visuellen und physikalischen Daten gleichzeitig und ermöglichen dadurch neue Anwendungsfelder – von der präventiven Arbeitssicherheit bis hin zu adaptiven Steuerungen in der Industrieproduktion.

Von der Vision zur Anwendung

Was auf den ersten Blick wie ein Spiel wirkt, ist in Wahrheit der Beginn einer neuen industriellen Realität. Technologien, die für Unterhaltung entwickelt wurden – Bewegungstracking, realistische Physik, adaptive Simulationen – schaffen heute Grundlagen für Training, Fertigung und Design. Das folgende Video zeigt, wie diese Verschmelzung aussieht: Wenn aus Spielmechanik Arbeitslogik wird und aus Unterhaltung Präzision entsteht.

Video: Von der Spielkonsole in die Industrie – Hightech trifft Praxis. Produktion: Visoric XR Studio 2025

Das Video macht deutlich, dass es hier nicht um Technologie allein geht, sondern um ein neues Denken: Bewegung als Steuerung, Erfahrung als Wissen, Raum als Benutzeroberfläche. Diese Prinzipien verändern, wie wir lernen, wie wir gestalten und wie wir in Echtzeit mit komplexen Systemen interagieren.

Unternehmen, die heute den Mut haben, Gaming-Technologien in ihre Arbeitsprozesse zu integrieren, investieren in mehr als Effizienz – sie investieren in Verständnis, Sicherheit und Zukunftsfähigkeit. Denn wer spielerisch lernt, kann ernsthaft besser handeln.

- Interaktive Simulationen ermöglichen sicheres Lernen und agile Entwicklung

- XR-Technologien aus dem Gaming bringen Dynamik in Training und Produktion

- Praxisorientierte Integration schafft messbaren Mehrwert für Mensch und Prozess

Wenn Sie darüber nachdenken, wie sich diese Technologien in Ihrem Unternehmen einsetzen lassen – ob für Schulung, Fertigung oder interaktive Präsentationen – sprechen Sie mit dem Expertenteam von Visoric in München. Gemeinsam entwickeln wir Lösungen, die genau dort ansetzen, wo Innovation spürbar werden soll: beim Menschen.

Mit Expertise in die Zukunft

Die Verschmelzung von Gaming, XR und Industrie ist kein ferner Trend mehr – sie geschieht jetzt, greifbar und wirtschaftlich relevant. Unternehmen, die früh beginnen, diese Technologien gezielt einzusetzen, verschaffen sich nicht nur Effizienzgewinne, sondern einen Vorsprung im Denken und Handeln. Doch der Weg dorthin erfordert Erfahrung, Technologieverständnis und ein Gefühl für den Menschen, der mit diesen Systemen arbeitet.

Das Münchner Visoric Expertenteam begleitet Unternehmen genau auf diesem Weg: von der Idee bis zur Anwendung. In interdisziplinären Projekten verbinden unsere Spezialisten technologische Innovation mit betrieblicher Realität. Das Ergebnis sind Lösungen, die nicht experimentell, sondern produktiv sind – klar messbar im Nutzen und sicher im Einsatz.

- Beratung und Umsetzung für XR-, KI- und Echtzeit-Visualisierung

- Integration von Gaming-Technologien in Industrie-, Service- und Schulungsprozesse

- Entwicklung individueller Showcases, Trainings- und Präsentationslösungen

Bild: Das Visoric Expertenteam in München macht aus Gaming Zukunftstechnologie für die Industrie. © Visoric GmbH 2025

Quelle: Visoric GmbH | München 2025

Wer Technologien aus dem Spiel in die Realität bringt, verändert nicht nur Arbeitsprozesse, sondern die Art, wie Menschen mit Maschinen, Daten und Wissen umgehen. Wenn Sie wissen möchten, wie dieser Wandel in Ihrem Unternehmen aussehen kann, sprechen Sie mit uns – das Visoric-Team zeigt Ihnen, was heute schon möglich ist.

Kontaktieren Sie uns:

E-Mail: info@xrstager.com

Telefon: +49 89 21552678

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@xrstager.com

Nataliya Daniltseva (Projektleiterin)

Mobil: +49 176 72805705

E-Mail: nataliya.daniltseva@xrstager.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München