Programmable Reality. Die neue Ära immersiver Out of Home Erlebnisse

Eine immersive LED Installation im urbanen Raum. Digitale Wellen brechen aus dem Display heraus und verschmelzen mit Licht und Nebel zu einer real wirkenden Szene.

Visualisierung: © Ulrich Buckenlei | XR Stager Magazin 2025

Wenn digitale Geschichten den Stadtraum betreten

Im urbanen Umfeld entstehen derzeit völlig neue Formen der visuellen Kommunikation. Die klassische LED Wand entwickelt sich zu einer Bühne, auf der digitale Inhalte nicht mehr im Bildschirm bleiben, sondern in die physische Umgebung hineinwirken. Das Prinzip der Programmable Reality verbindet Animation, Wasser, Licht, Nebel und Sound zu einer abgestimmten Choreografie, die reale Reaktionen erzeugt und so zu einem unmittelbar spürbaren Erlebnis wird.

Als Industrieanalyst beobachte ich, wie sich diese immersive Out of Home Technologie zu einem eigenständigen Medium entwickelt. Städte werden zu erzählbaren Räumen, Markeninszenierungen zu räumlichen Momenten und Passanten zu Teilnehmenden einer Echtzeitgeschichte. An der Schnittstelle von LED Architektur, Echtzeitsteuerung und physikalischen Effekten entsteht ein Format, das weit über traditionelle Außenwerbung hinausgeht und den öffentlichen Raum in ein narratives Erlebnisfeld verwandelt.

Immer deutlicher wird, dass die Frage nicht lautet, ob sich digitale und physische Ebenen verbinden, sondern wie präzise sie aufeinander abgestimmt werden können. Installationen, die Wasserstöße, atmosphärischen Nebel oder dynamische Lichtsequenzen millisekundengenau mit visuellen Inhalten koppeln, zeigen, wie aus reiner Projektion ein räumliches Ereignis wird. Programmable Reality beschreibt genau diese neue Qualität: eine erzählerische Ebene, die digital beginnt und physisch weiterlebt.

- Digitale Inhalte werden räumlich → Animationen erzeugen reale Reaktionen im Stadtraum

- Präzise Choreografie → Wasser, Licht, Nebel und Sound folgen dem visuellen Timing

- Neue Erlebnisebene → Out of Home wird zum immersiven Medium, das physisch spürbar ist

Nach diesem ersten Eindruck stellt sich die Frage, wie eine solche Installation technisch aufgebaut ist. Die Wirkung entsteht nicht zufällig, sondern durch ein präzises Zusammenspiel aus digitalen Inhalten und physikalischen Effekten. Um zu verstehen, wie Programmable Reality funktioniert, lohnt sich ein Blick auf die einzelnen Ebenen, die eine Szene wie diese erst möglich machen.

Wie Programmable Reality funktioniert: Die technischen Ebenen hinter der Illusion

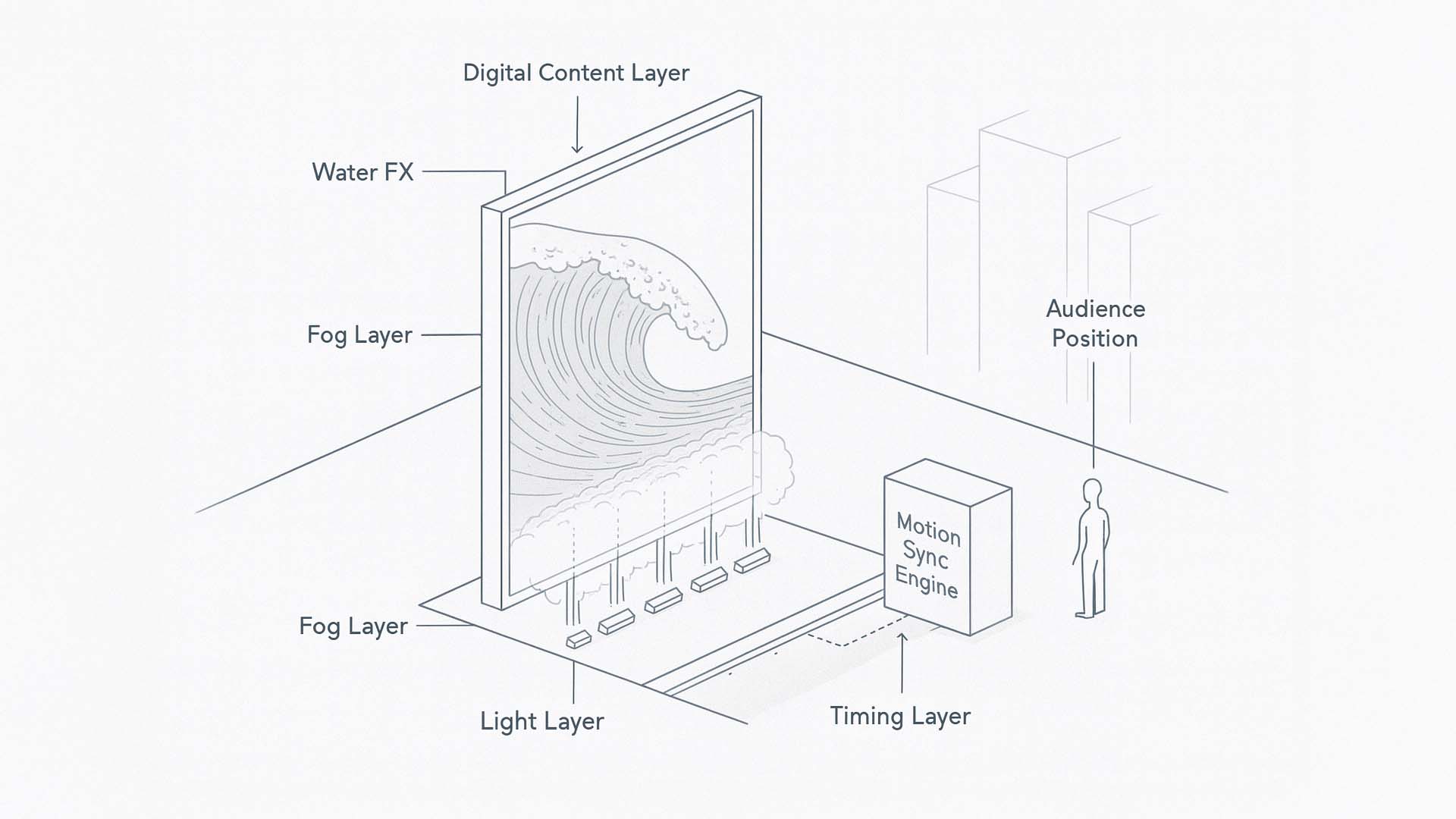

Programmable Reality lebt nicht von einem einzelnen Effekt. Die Wirkung entsteht erst dann, wenn digitale Inhalte, physikalische Effekte und eine präzise Steuersynchronisation miteinander verschmelzen. Die Szene, die im ersten Bild zu sehen ist, zeigt genau diese Zusammenführung. Ein LED-Screen bildet die visuelle Ebene, während Wasser, Nebel und Licht als reale physische Layer darübergelegt werden. Beide Welten interagieren in Echtzeit und verwandeln eine statische Fassade in ein dynamisch reagierendes Erlebnis. Damit diese immersive Schichtung funktioniert, müssen mehrere technische Systeme auf Millisekundenbasis zusammenarbeiten.

Die folgende Visualisierung zeigt die zentralen Bausteine eines solchen Systems und macht sichtbar, wie digitale und physische Elemente zu einer einzigen erzählerischen Fläche verschmelzen.

Technische Funktionsgrafik: Digitale Inhalte, Wasser, Nebel, Licht und Motion Sync verschmelzen zu einem einzigen immersiven Erlebnissystem.

Visualisierung: © Ulrich Buckenlei | XR Stager Magazin 2025

Die Grafik zeigt die funktionalen Ebenen des Systems. Im Zentrum steht der große LED-Screen, der als Ausgangspunkt für alle Reaktionen dient. Der Content bestimmt die Wellenform, die Bewegungsenergie und den dramaturgischen Verlauf der Szene. Diese Bewegungsmuster werden in Echtzeit von der Motion Sync Engine analysiert und als Steuerinformationen an die physischen Effektmodule weitergegeben.

- Digital Content Layer → Der LED-Screen erzeugt die visuelle Erzählung. Wasserwellen, Farbverläufe oder rhythmische Animationen definieren die Impulse, die später physisch umgesetzt werden.

- Real Water FX → Vor dem Screen befinden sich gerichtete Wasserfontänen. Sie reagieren auf Bewegung, Energie und Rhythmus des digitalen Inhalts und brechen aus der flachen Darstellung in den realen Raum aus.

- Atmospheric Fog Layer → Nebel bildet die Volumetrik zwischen Screen und Straße. Er dient als dreidimensionaler Träger für Licht, Farbe und Bewegung und verbindet visuelle und reale Raumebenen.

- Reactive Light Layer → Lichtquellen in der Umgebung modulieren Intensität und Farbe in Abhängigkeit vom LED-Content. Dadurch erweitert sich die digitale Szene über den Bildschirm hinaus in die Architektur und den öffentlichen Raum.

- Motion Sync Engine → Die zentrale Steuerschicht. Sie erkennt Muster, Bewegungsimpulse und Schlüsselereignisse im Screen-Content und übersetzt diese in präzise physikalische Effekte. Sie ist das Herz der Programmable Reality.

- Timed FX Controller → Ein Timingmodul sorgt dafür, dass Wasserstöße, Nebelpulse und Lichtimpulse auf Millisekunden genau mit der Animation übereinstimmen. Die Wirkung entsteht nur dann, wenn alles im gleichen Moment reagiert.

- Audience Perspective → Die Position der Betrachtenden ist Teil der Planung. Die physische Tiefe entsteht erst aus dem Winkel, in dem Screen, Wasser und Nebel zusammenspielen.

In Kombination erzeugen diese Bausteine ein immersives System, das nicht mehr zwischen digital und physisch trennt. Der LED-Screen liefert die narrative Führung. Die Wasserfontänen setzen die Bewegungsenergie in echte Kraft um. Der Nebel gibt der Szene räumliche Tiefe und verbindet Licht, Farbe und Materialwirkung. Die Lichtlayer transportieren die Emotion über den sichtbaren Rahmen hinaus. Die gesamte Choreografie wird von der Motion Sync Engine orchestriert, die jede Änderung im Bildmaterial sofort in physische Signale übersetzt.

Programmable Reality zeigt damit eine neue Entwicklungsstufe: Öffentliche Räume werden zu erzählerischen Umgebungen, die nicht länger nur bespielt werden, sondern aktiv auf Inhalte reagieren. Die Grenze zwischen Szene und Stadt löst sich auf und digitale Geschichten greifen in den realen Raum über.

Nachdem die technischen Ebenen sichtbar geworden sind, rückt nun die Frage in den Mittelpunkt, welche Komponente die gesamte Installation steuert. Im nächsten Kapitel geht es um die Motion Sync Engine und ihre Rolle als zentrales System, das visuelle Impulse erkennt und in präzise physische Reaktionen übersetzt.

Die Motion Sync Engine als zentrales Steuersystem immersiver Installationen

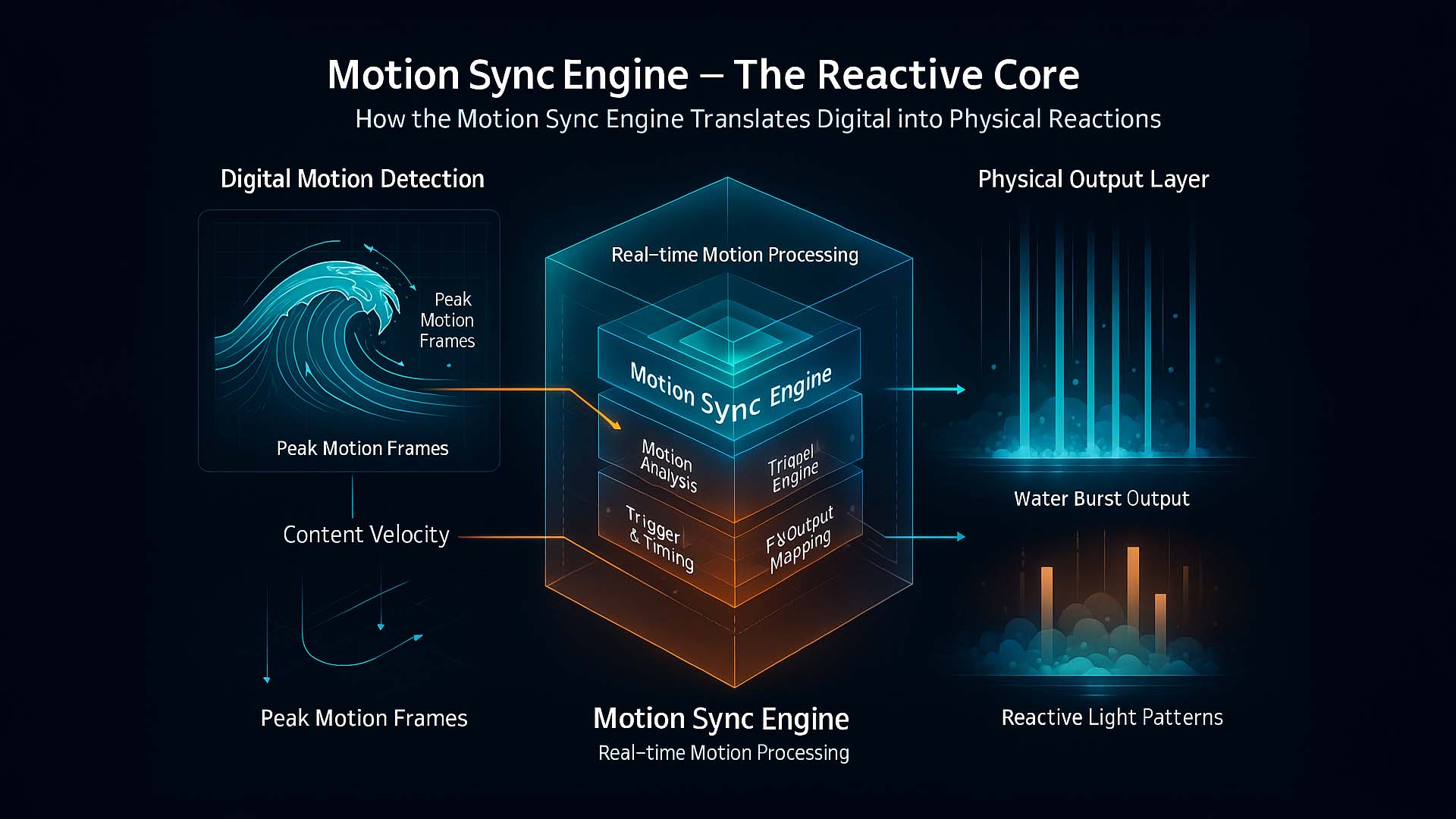

Damit digitale Bilder und physische Effekte zu einer einzigen fließenden Erfahrung verschmelzen können, braucht es ein System, das visuelle Impulse nicht nur erkennt, sondern sie augenblicklich in reale Bewegung übersetzt. Die Motion Sync Engine übernimmt genau diese Aufgabe. Sie ist das Analysezentrum der Installation und reagiert in dem Moment, in dem sich auf dem LED Bildschirm ein dynamischer Bildausschnitt verändert. Jede Welle, jede Farbverdichtung und jeder Bewegungsimpuls wird zu einem steuerbaren Signal, das den realen Raum erweitert und sichtbar macht, wie eng digitale und physische Ebenen miteinander verbunden sein können.

Die folgende Visualisierung zeigt, wie dieser Prozess aufgebaut ist. Links erkennt man den digitalen Ursprung der Szene. Die Wellenstruktur wird in Bewegungsdaten zerlegt, die Geschwindigkeit, Richtung und Intensität abbilden. Diese Motion Frames werden in die Mitte geleitet, wo die Motion Sync Engine ihre Analyse durchführt. Sie prüft, welche Bildbereiche besonders aktiv sind, berechnet Muster und entscheidet, welche Effekte in welchem Moment ausgelöst werden. Rechts sieht man die physische Ebene, in der Wasserstöße, Nebel und Licht auf die zuvor verarbeiteten Informationen reagieren. Die Grafik macht sichtbar, wie aus einer zweidimensionalen Bewegung eine räumliche und physische Erfahrung entsteht.

Motion Sync Engine: Die technische Funktionsgrafik zeigt, wie digitale Bewegungen erkannt, analysiert und in präzise physische Effekte übersetzt werden.

Visualisierung: © Ulrich Buckenlei | XR Stager Magazin 2025

Die Visualisierung verdeutlicht jedoch nur einen Teil des Prozesses. Hinter der Engine laufen kontinuierliche Berechnungen, die sicherstellen, dass Effekte nicht zu früh, zu spät oder in zu hoher Intensität ausgelöst werden. Die Engine beobachtet zudem die Gesamtdynamik der Szene und sorgt dafür, dass Wasser, Nebel und Licht nicht isoliert, sondern als abgestimmte Einheit wirken. Auf diese Weise bleibt die Installation stabil, glaubwürdig und wiederholbar, ohne ihren lebendigen Charakter zu verlieren.

- Digital Motion Frames → Bewegungsdaten des LED Inhalts werden in Geschwindigkeit, Richtung und Intensität zerlegt.

- Motion Analysis Core → Die Engine erkennt Muster und priorisiert die dynamischsten Bereiche der visuellen Bewegung.

- Trigger and Timing Module → Dieses Modul berechnet präzise Auslösezeitpunkte, damit Wasser, Nebel und Licht im gleichen Moment reagieren.

- Output Mapping → Die verarbeiteten Impulse werden den dazugehörigen Effektmodulen zugewiesen und in reale Aktionen übersetzt.

- Physical FX Layer → Wasserstöße, Nebelschichten und Lichtstimmungen erzeugen eine physische Ausdehnung der digitalen Szene.

Besonders wichtig ist der Umstand, dass die Motion Sync Engine nicht mit vorgefertigten Sequenzen arbeitet. Sie reagiert live auf das digitale Bild. Jede Bewegung auf dem Bildschirm wird unmittelbar in eine Aktion im Raum übersetzt. Dadurch entsteht kein wiederholtes Muster, sondern ein Erlebnis, das sich organisch anfühlt und dennoch vollständig kontrolliert bleibt. Genau diese Verbindung aus Echtzeitreaktion und Präzision macht die Illusion möglich und zeigt, warum Programmable Reality eine neue Erlebnisqualität schafft.

Im nächsten Kapitel geht es um die Systemebene hinter dieser Echtzeitfähigkeit. Dabei wird sichtbar, wie verschiedene Effektmodule, Sensoren und Steuergeräte miteinander kommunizieren und warum ihre Verzahnung entscheidend für immersive Installationen ist, die sich nahtlos in den realen Raum einfügen.

Systemarchitektur in Echtzeit: Wie alle Komponenten zu einem Gesamtsystem werden

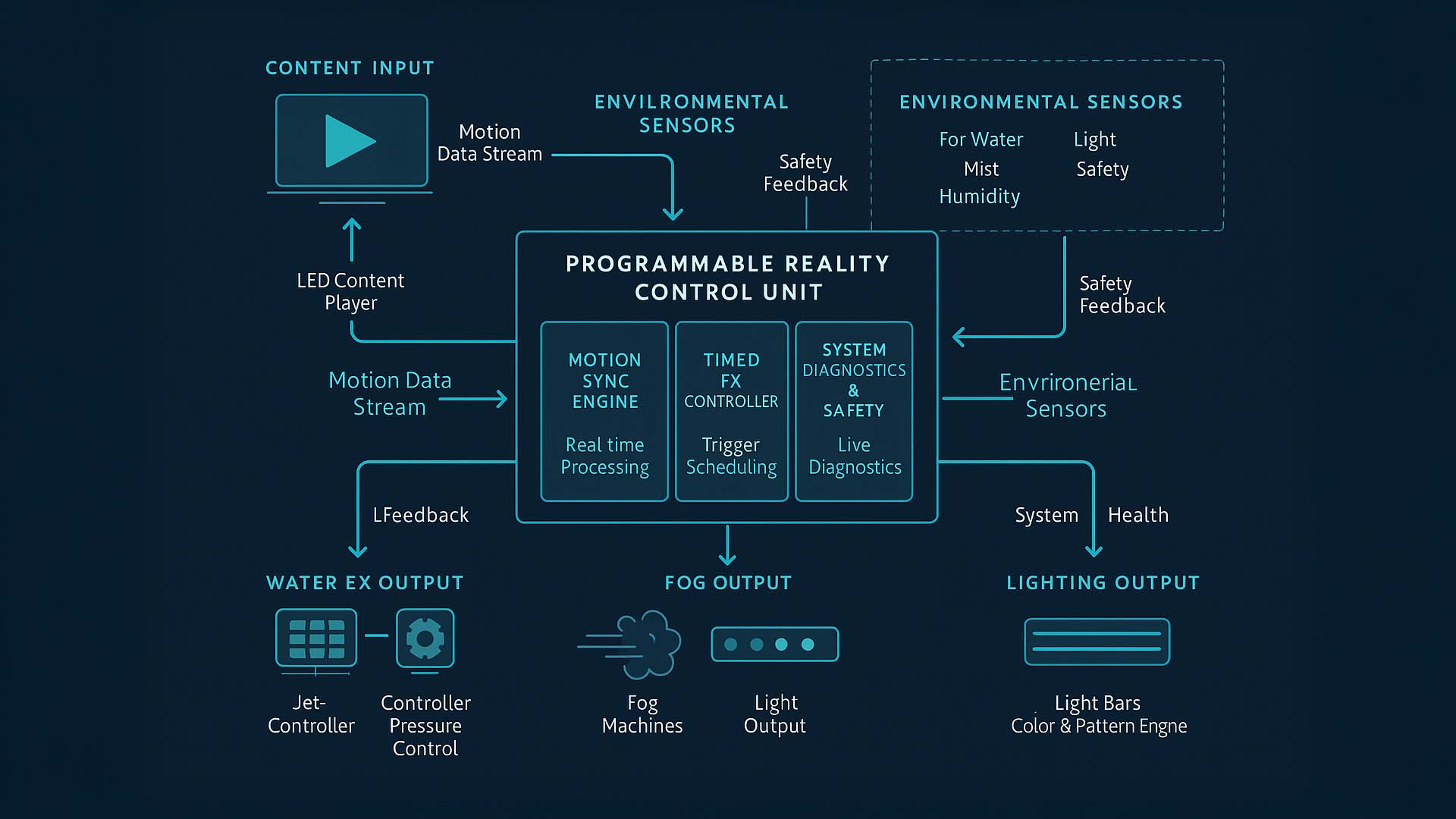

Damit eine immersive Installation nicht nur in Momenten, sondern über Stunden und Tage hinweg zuverlässig funktioniert, braucht es mehr als eine starke Bildidee und eine präzise Motion Sync Engine. Im Hintergrund arbeitet eine Systemarchitektur, die Inhalte, Effektmodule, Sensoren und Sicherheitslogiken miteinander verbindet. Sie stellt sicher, dass jede Bewegung auf dem LED Screen, jede Wasserfontäne, jede Nebelschicht und jeder Lichtimpuls in einem konsistenten Regelkreis laufen. Erst diese Systemebene macht aus einzelnen Effekten ein belastbares Erlebnis, das in der Öffentlichkeit betrieben werden kann.

Die folgende Visualisierung zeigt diese Architektur in drei Ebenen. Oben beginnt der Weg beim Content Input. Ein LED Content Player liefert den visuellen Inhalt, aus dem ein Motion Data Stream erzeugt wird. Parallel dazu erfassen Environmental Sensors in der Umgebung Werte zu Wasser, Nebel, Feuchtigkeit, Licht und Sicherheit. Beide Datenströme laufen in die mittlere Ebene, die Programmable Reality Control Unit. In diesem Kernblock arbeiten drei zentrale Module zusammen: Die Motion Sync Engine übernimmt die Echtzeitanalyse des Motion Streams, der Timed FX Controller plant und strukturiert die Auslösezeitpunkte der Effekte, und die Ebene System Diagnostics and Safety überwacht den Gesamtzustand der Installation mit laufenden Diagnosen. Aus dieser Einheit heraus werden die Effekte an die physische Ebene weitergegeben.

Programmable Reality System Architecture: Content Input, Control Unit und physische Ausgänge bilden einen geschlossenen Echtzeitkreislauf für Wasser, Nebel und Licht.

Visualisierung: © Ulrich Buckenlei | XR Stager Magazin 2025

Im unteren Teil der Grafik werden die physischen Ausgänge sichtbar. Links befindet sich der Bereich Water FX Output, gesteuert über einen Jet Controller und eine Pressure Control, die Druck und Muster der Wasserstöße regeln. In der Mitte liegt der Fog Output, der Nebelmaschinen und Lichtausgaben koordiniert, damit Volumen, Dichte und Sichtbarkeit präzise zum visuellen Inhalt passen. Rechts folgt der Lighting Output, in dem Lichtleisten und eine Color and Pattern Engine dafür sorgen, dass Farben, Helligkeit und Muster exakt auf die digitale Szene abgestimmt sind. Von allen Ausgängen führen Rückkopplungslinien zurück in die Control Unit, über die System Health und Feedbackdaten zurückgemeldet werden. So entsteht ein geschlossener Regelkreis, in dem jede Aktion mit einer Rückmeldung beantwortet wird.

- Content Input → Ein LED Content Player liefert den visuellen Inhalt und erzeugt einen kontinuierlichen Motion Data Stream.

- Environmental Sensors → Sensoren überwachen Wasser, Nebel, Feuchtigkeit, Licht und Sicherheitsparameter und geben Safety Feedback an die Control Unit.

- Programmable Reality Control Unit → Die zentrale Steuereinheit bündelt Motion Sync Engine, Timed FX Controller sowie System Diagnostics and Safety.

- Motion Sync Engine → Analysiert Bewegungsdaten in Echtzeit und entscheidet, welche Effekte wann ausgelöst werden.

- Timed FX Controller → Plant Auslösezeitpunkte und sorgt dafür, dass physische Effekte strukturiert und reproduzierbar ablaufen.

- System Diagnostics and Safety → Überwacht den Zustand aller Module und stellt sicher, dass die Installation innerhalb definierter Sicherheitsgrenzen arbeitet.

- Water FX Output → Jet Controller und Pressure Control setzen digitale Bewegungsimpulse in gerichtete Wasserstöße um.

- Fog Output → Nebelmaschinen und Lichtausgabe erzeugen ein atmosphärisches Volumen, das die Szene räumlich erweitert.

- Lighting Output → Lichtleisten und eine Color and Pattern Engine verlängern die digitale Geschichte in den umgebenden Raum.

Was in der Grafik nur angedeutet ist, wird in der Praxis zum entscheidenden Erfolgsfaktor. Die Control Unit synchronisiert nicht nur Effekte, sie moderiert auch Grenzen: Wie stark darf der Wasserdruck steigen, wie dicht darf der Nebel sein, welche Lichtintensität ist bei bestimmten Umgebungsbedingungen sinnvoll. Die Installation wird damit zu einem adaptiven System, das sich zwischen kreativer Freiheit und technischer Verantwortung bewegt. Nur wenn diese Systemebene stabil arbeitet, kann Programmable Reality im Alltag bestehen und sich nahtlos in den realen Raum einfügen.

Im nächsten Kapitel verschiebt sich der Blick von der Technik hin zur Anwendung. Dort geht es darum, wie Marken, Städte und Betreiber diese Systeme nutzen können, um öffentliche Räume erzählerisch zu aktivieren und welche neuen Formen von räumlichem Storytelling dadurch entstehen.

Wie Marken und Städte öffentliche Räume in erzählerische Erlebnisse verwandeln

Programmable Reality verändert nicht nur die technische Struktur von Out-of-Home Installationen, sie verändert ihre Bedeutung. Immer mehr Marken, Städte und Betreiber nutzen diese Systeme, um nicht nur Inhalte zu zeigen, sondern Räume zu aktivieren. Wenn digitale Szenen physisch in den Stadtraum übergreifen, entsteht eine neue Form des Storytellings, die nicht nur gesehen, sondern gespürt wird. Menschen bleiben stehen, interagieren und interpretieren – die Installation wird zu einer Bühne, der Stadtraum selbst zum Medium.

Die folgende Visualisierung zeigt genau diese Idee: Eine großformatige LED-Installation projiziert eine leuchtende astronomische Szene in ein urbanes Umfeld. Nebel am Boden erweitert die digitale Darstellung in den realen Raum, während reflektierende Oberflächen der Umgebung das Licht aufnehmen und Passanten umgeben. Das Zusammenspiel aus digitaler Story, atmosphärischen Effekten und realer Architektur erzeugt eine räumliche Erzählung, die weit über klassische Außenwerbung hinausgeht.

Immersive Urban Activation: Digitale Inhalte, Raumlicht und atmosphärische Effekte verschmelzen zu einem räumlichen Erlebnis, das Passanten unmittelbar einbezieht.

Visualisierung: © Ulrich Buckenlei | XR Stager Magazin 2025

Solche Szenen zeigen, wie sich öffentliche Plätze in erzählerische Räume verwandeln können. Eine Marke erzählt nicht mehr linear, sondern räumlich. Städte schaffen atmosphärische Akzente, die Kultur, Innovation und Identität sichtbar machen. Und Betreiber entdecken ein neues Format, das zwischen Kunst, Interaktion und Information vermittelt. Die Installation wird damit nicht nur zu einem Medium, sondern zu einer sozialen Erfahrung.

- Urbanes Storytelling → Plätze, Fassaden und Wege werden zu Erzählebenen, die digitale Inhalte räumlich wirken lassen.

- Markenerlebnisse im Raum → Unternehmen erzeugen nicht nur Sichtbarkeit, sondern physisch spürbare Szenen, die Menschen anziehen und verweilen lassen.

- Kulturelle Aktivierung → Städte nutzen immersive Installationen, um Plätze atmosphärisch aufzuwerten und Gemeinschaftserlebnisse zu schaffen.

- Räumliche Interaktion → Passanten werden Teil der Erzählung und prägen die Wahrnehmung des Moments durch ihre Anwesenheit.

- Neue Formate für OOH → Out-of-Home wird zur Erlebnisoberfläche, die weit über digitale Screens hinausgeht und physische Tiefe gewinnt.

Diese neue Art der Raumgestaltung zeigt, wie schnell sich die Grenzen zwischen digitalen und physischen Erlebnissen auflösen. Im nächsten Schritt geht es darum, wie solche Szenen filmisch erzählt werden können und welche Rolle Bewegtbild in der Dokumentation und Weiterverbreitung immersiver Installationen spielt.

Das Erlebnis im Bewegtbild: Wie sich die Installation filmisch erschließt

Immersive Installationen entfalten ihre volle Wirkung erst dann, wenn man sie in Bewegung erlebt. Wasserstöße, Lichtimpulse, Nebelschwaden und digitale Inhalte reagieren präzise aufeinander und erzeugen eine Dynamik, die im Standbild nur angedeutet werden kann. Das folgende Video zeigt daher die Installation in Echtzeit und macht sichtbar, wie die einzelnen Ebenen ineinandergreifen.

Original installation: Disney Immersive Billboard.

Base footage: Public social media source. Scripting, narration & graphics: Ulrich Buckenlei.

Das Video dokumentiert den Moment, in dem digitale Animation, physische Effekte und Raumverhalten zu einer einzigen Erzählung verschmelzen. Es zeigt, wie präzise die Motion Sync Engine arbeitet und wie räumlich erlebbar Programmable Reality im urbanen Umfeld wird.

Mit Experten sprechen: Wie sich immersive Technologien sinnvoll einsetzen lassen

Immersive Technologien verändern, wie Marken kommunizieren, wie Städte gestalten und wie Menschen Räume erleben. Viele Unternehmen stehen heute an einem Punkt, an dem sie Potenziale erkennen, aber noch Orientierung suchen. Ob es um technische Rahmenbedingungen, kreative Ansätze oder die Realisierbarkeit komplexer Installationen geht – ein fachlicher Austausch bringt hier oft entscheidende Klarheit.

Visoric: Ihr Expertenteam für immersive Technologien und digitale Transformation.

Visualisierung: © Ulrich Buckenlei | Visoric Newsroom München

Das Visoric Expertenteam in München begleitet Organisationen dabei, immersive Lösungen sinnvoll zu planen, zu bewerten und umzusetzen. In gemeinsamen Gesprächen entstehen klare Wege, realistische Roadmaps und oft auch völlig neue Ideen, die zuvor nicht sichtbar waren. Wenn Sie überlegen, wie immersive Systeme zu Ihren Zielen passen könnten, freuen wir uns auf den Austausch.

- Strategische Einschätzung → Wie immersive Technologien Wert schaffen und wo sie sinnvoll eingesetzt werden können.

- Technische Orientierung → Welche Systeme, Schnittstellen und Datenflüsse erforderlich sind.

- Machbarkeit und Umsetzung → Was realisierbar ist und wie Projekte effizient geplant werden.

Wir laden Sie herzlich ein, mit uns ins Gespräch zu kommen und gemeinsam neue Perspektiven für Ihre Marke, Ihr Unternehmen oder Ihre Stadt zu entwickeln.

Kontaktieren Sie uns:

E-Mail: info@xrstager.com

Telefon: +49 89 21552678

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@xrstager.com

Nataliya Daniltseva (Projektleiterin)

Mobil: +49 176 72805705

E-Mail: nataliya.daniltseva@xrstager.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München