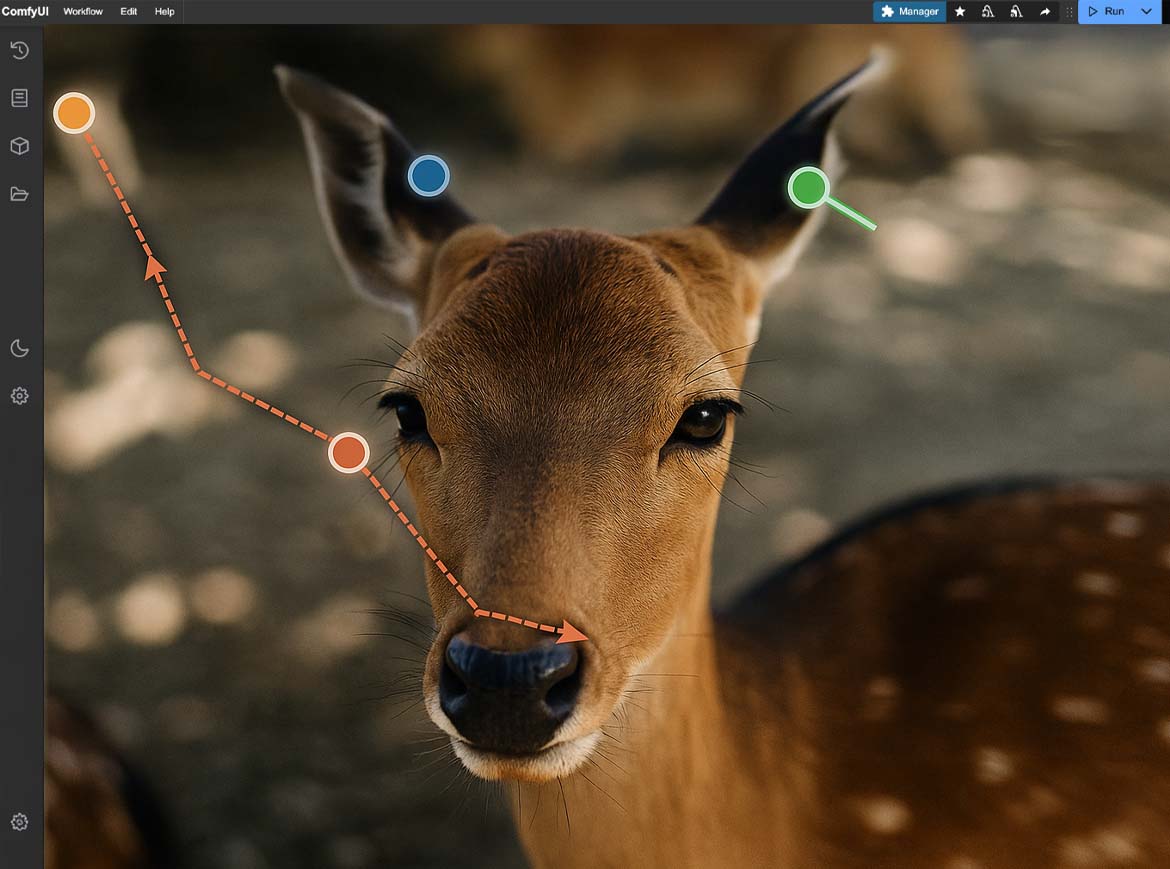

Das User-Interface in Marey (Visualisierung)

Visualisierung: Ulrich Buckenlei

Marey AI Film Generation – Eine neue Ära der automatisierten 3D-Produktion

Künstliche Intelligenz transformiert die 3D-Filmproduktion. Mit Marey, entwickelt vom kalifornischen KI-Studio Moonvalley, entstehen cineastische Sequenzen automatisch – basierend auf Text- oder Bildvorgaben. Die Software kombiniert fortschrittliche Sprachverarbeitung, computergenerierte Animation und multimodale Szenensynthese zu einem radikal neuen Produktionsansatz.

Moonvalley wurde 2021 von einem interdisziplinären Team aus KI-Forschern, Game-Entwicklern und Filmtechnologen gegründet. Seitdem fokussiert sich das Unternehmen auf generative Medienlösungen für professionelle Kreativindustrien. Marey wurde erstmals im Frühjahr 2023 vorgestellt und ist seit Mitte 2024 in einer Betaversion für ausgewählte Studios, Agenturen und Forschungspartner verfügbar.

Marey gilt als eine der ersten vollintegrierten KI-Plattformen für automatisierte Filmszenen. Statt klassischem Storyboard- oder Animationsworkflow entstehen Regie, Kameraarbeit, Bewegung, Licht und Sounddesign direkt aus strukturierten Prompts – und das in hoher visueller Qualität.

Der Zugang ist aktuell stark limitiert: Interessierte Organisationen müssen sich über die Moonvalley-Website registrieren und werden nach Projektprüfung eingeladen. Zielgruppe sind professionelle Kreativteams, mediennahe Forschungseinrichtungen und Studios mit Fokus auf AI-generiertes Storytelling. Eine offene Version für Endnutzer ist derzeit nicht geplant.

Im Visoric-Newsroom analysieren wir diese Entwicklung und zeigen konkrete Potenziale und Herausforderungen für Medienhäuser, Agenturen und 3D-Produktionsstudios.

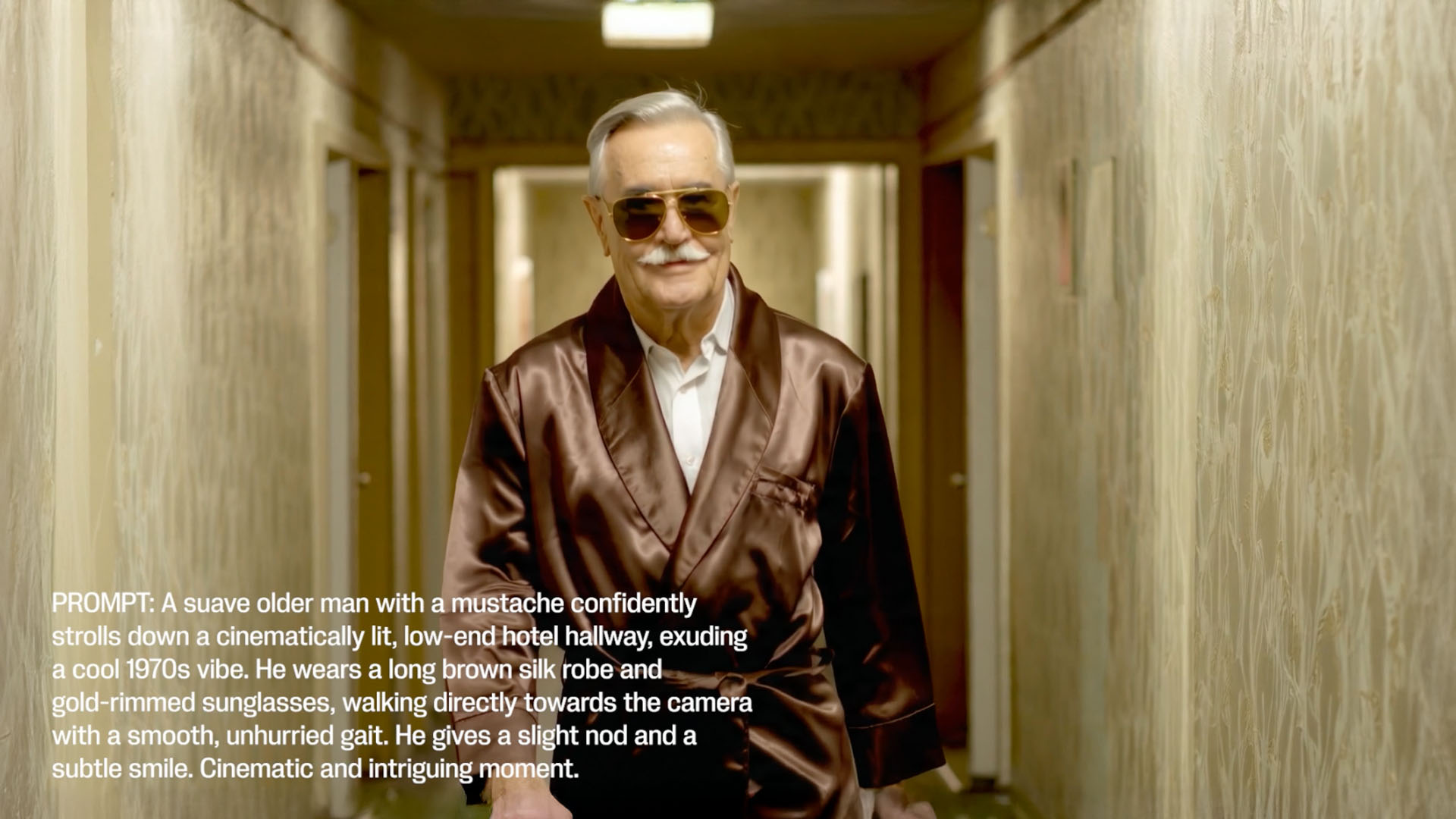

Beispielhafte Filmszene, erzeugt mit der KI-Software Marey vom US-Entwickler Moonvalley

[Image: Moonvalley]

Konzept: Text- und Bildprompts als Regieanweisung

Marey basiert auf der Idee, filmische Szenen nicht mehr manuell zu inszenieren, sondern aus textlichen oder visuellen Eingaben vollständig generieren zu lassen. Die Software interpretiert Prompts als Regieanweisungen und erstellt daraus dynamische Sequenzen mit Schnitt, Kamerabewegung, Motion Design, Lichtsetzung und Ton – alles in einem konsistenten, cineastischen Stil.

Der Schlüssel liegt in der semantischen Übersetzung: Marey analysiert nicht nur, was inhaltlich dargestellt werden soll, sondern auch, wie dies filmsprachlich zu inszenieren ist. Emotionale Übergänge, Kameraachsen und Bewegungslogik werden automatisch erkannt und dramaturgisch verknüpft.

- Prompt-to-Sequence – Vollständige Filmszenen entstehen aus wenigen Textelementen

- Semantische Inszenierung – Inhalt und filmische Umsetzung greifen logisch ineinander

- Multimodales Output – Visuelle, akustische und dynamische Ebenen sind integriert

Vollständige Filmszenen entstehen aus wenigen Textelementen

[Image: Moonvalley]

Mit Marey verändert sich die Art, wie Geschichten filmisch umgesetzt werden: Statt Szenen mühsam zu animieren oder zu drehen, geben Kreative lediglich Textvorgaben ein – die Software übernimmt Regie, Kamera, Bewegung und Sounddesign. Die Vorstellungskraft ersetzt klassische Produktionsmittel. Marey interpretiert diese Vorgaben mit filmischer Logik und erzeugt daraus kohärente, dynamische Sequenzen. Der kreative Fokus verschiebt sich dadurch von handwerklicher Ausführung hin zur konzeptionellen Steuerung: Nicht das manuelle Erstellen einzelner Bilder steht im Vordergrund, sondern das gezielte Formulieren von Ideen, die das System eigenständig visualisiert. Für Studios und Agenturen bedeutet das ein radikales Umdenken – aber auch ein enormes Potenzial für Tempo, Vielfalt und künstlerische Präzision.

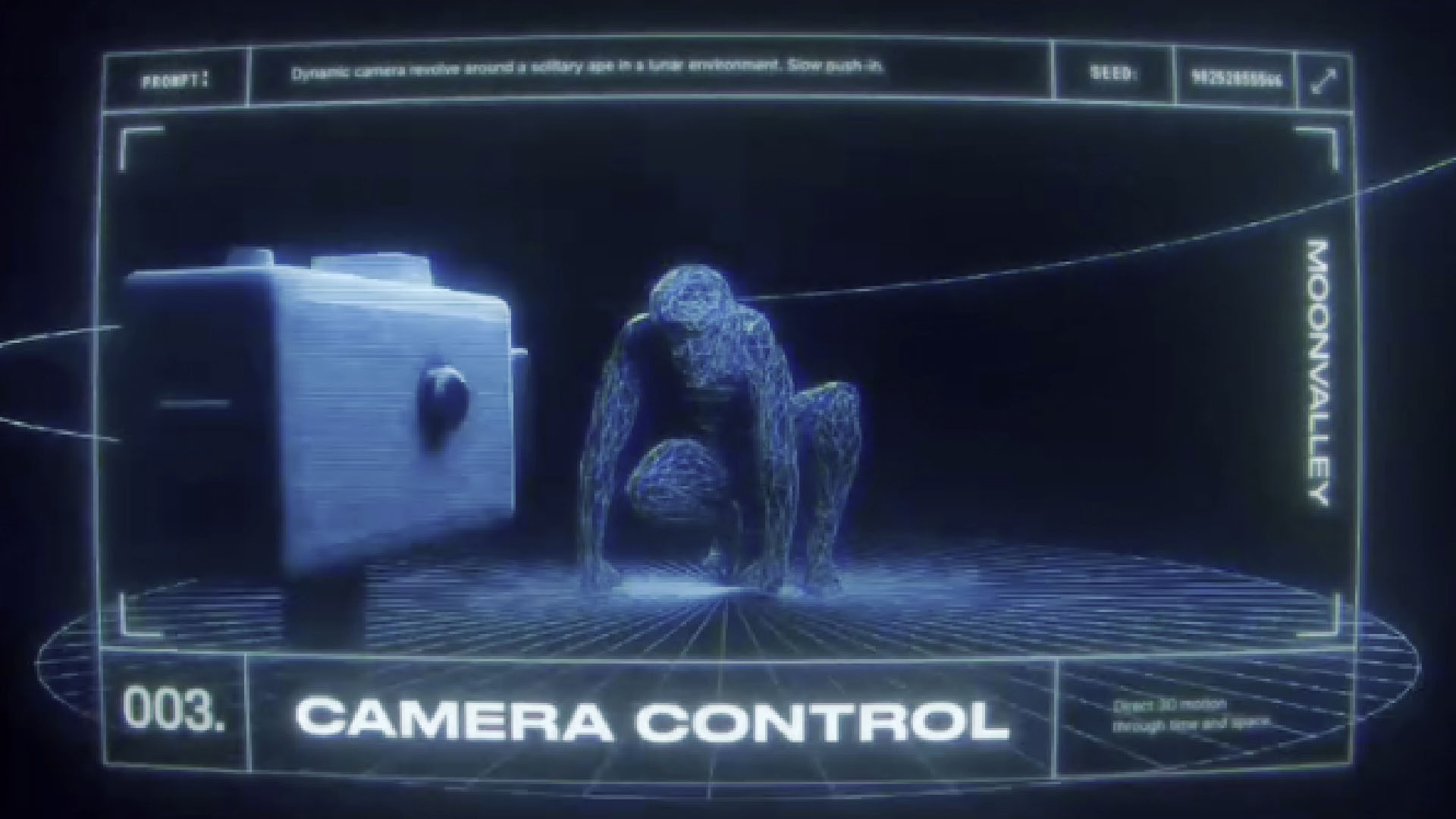

Technischer Workflow und Architektur

Marey basiert auf einem modularen, KI-gestützten Produktionssystem, das text- oder bildbasierte Eingaben in cineastische Bewegtbildsequenzen überführt. Die technische Architektur verbindet unterschiedliche AI-Engines für Storyauswertung, Kameraregie, Lichtsetzung, Sounddesign und Filmschnitt zu einem konsistenten Ausgabesystem. Dabei werden eingehende Prompts in semantische Filmbausteine übersetzt, darunter Shot-Größen, Kamerabewegungen, Perspektivwechsel oder Interaktionen im Raum.

Ein wesentliches Feature ist die Möglichkeit, Objektpfade direkt zu definieren: So lassen sich Bewegungsverläufe zeichnen, denen Figuren oder Fahrzeuge exakt folgen – inklusive physikalischer Parameter wie Beschleunigung, Gewicht und Timing. Diese Pfade können in Echtzeit angepasst werden, sodass kreative Änderungen am Layout, der Choreografie oder dem Tempo direkt im AI-Modell berücksichtigt werden. Auch Layer wie Stil, Kamerarichtung oder Bewegungsfrequenz lassen sich unabhängig voneinander variieren und kombinieren.

Trotz der Automatisierung erlaubt das System ein hohes Maß an Individualisierung. Über Asset-Bibliotheken, benutzerdefinierte Style-Guides oder Look-Up-Tables (LUTs) lassen sich spezifische Markenwelten abbilden. So entsteht kein generischer Output, sondern ein kuratiertes Filmgefühl, das sich an den visuellen Vorgaben des jeweiligen Kreativteams orientiert

- Stärken – Hohe Produktionsgeschwindigkeit, kreative Freiheit, visuelle Vielfalt

- Grenzen – Inkonsistente Charakterdarstellung, repetitive Muster, fehlende Langzeitkohärenz

- Wünsche – Feiner steuerbare Stilparameter, stabilere Szenenlogik, besseres Feedbacksystem

Bewegungen folgen definierten Pfaden mit physikalischer Dynami

[Image: Moonvalley]

Diese technische Architektur ermöglicht die intelligente Steuerung filmischer Ausdrucksformen, ohne dass Anwender klassisches 3D- oder Filmschnitt-Know-how benötigen. Besonders für Agenturen, Prototyping-Teams und AI-Creator eröffnet das System eine neue Produktionslogik zwischen Automatisierung und Stilhoheit.

Natürlich – hier ist das Kapitel professionell überarbeitet, klar strukturiert und sprachlich an den vorherigen Abschnitt angepasst:

Nutzererfahrungen und Herausforderungen

Erste Rückmeldungen von professionellen Anwendern zeigen ein deutliches Bild: Marey beschleunigt kreative Workflows erheblich und verschiebt den Fokus von technischer Umsetzung hin zur konzeptuellen Gestaltung. Die Möglichkeit, in kürzester Zeit vollwertige Szenenvarianten zu generieren, führt zu einer agilen Erzählweise – insbesondere in frühen Konzeptphasen oder bei der Entwicklung alternativer Visualisierungen.

Gleichzeitig berichten Nutzer auch von typischen Limitierungen generativer Systeme. Die stilistische Konsistenz über längere Zeiträume hinweg kann schwanken, insbesondere bei wiederkehrenden Figuren oder Locations. Auch die Detailkontrolle über Mimik, Timing oder spezifische Kamerapositionen ist nur eingeschränkt möglich – was eine präzise und durchdachte Prompt-Struktur notwendig macht. Zunehmend entscheidend wird daher die Fähigkeit zur Prompt Literacy: Nur wer semantisch klar und kreativ formuliert, kann das System gezielt steuern und zu konsistenten Ergebnissen führen.

Diese Erfahrungen fließen aktiv in die Weiterentwicklung der Plattform ein. Die Community rund um Marey wünscht sich mehr Kontrolle über Timing, Übergänge und Charakterkohärenz – aber auch Werkzeuge für personalisierte Stile oder modulare Szenenentwicklung.

- Stärken – Hohe Produktionsgeschwindigkeit, kreative Freiheit, visuelle Vielfalt

- Grenzen – Inkonsistente Charakterdarstellung, repetitive Muster, fehlende Langzeitkohärenz

- Wünsche – Feiner steuerbare Stilparameter, stabilere Szenenlogik, besseres Feedbacksystem

Hohe Produktionsgeschwindigkeit, kreative Freiheit, visuelle Vielfalt

[Image: Moonvalley]

Die Praxis zeigt: Marey ist kein Ersatz für künstlerische Vision – aber ein kraftvolles Werkzeug, um Ideen in hoher Qualität und Geschwindigkeit zu konkretisieren. Die Herausforderung liegt in der intelligenten Koordination von Mensch und Maschine.

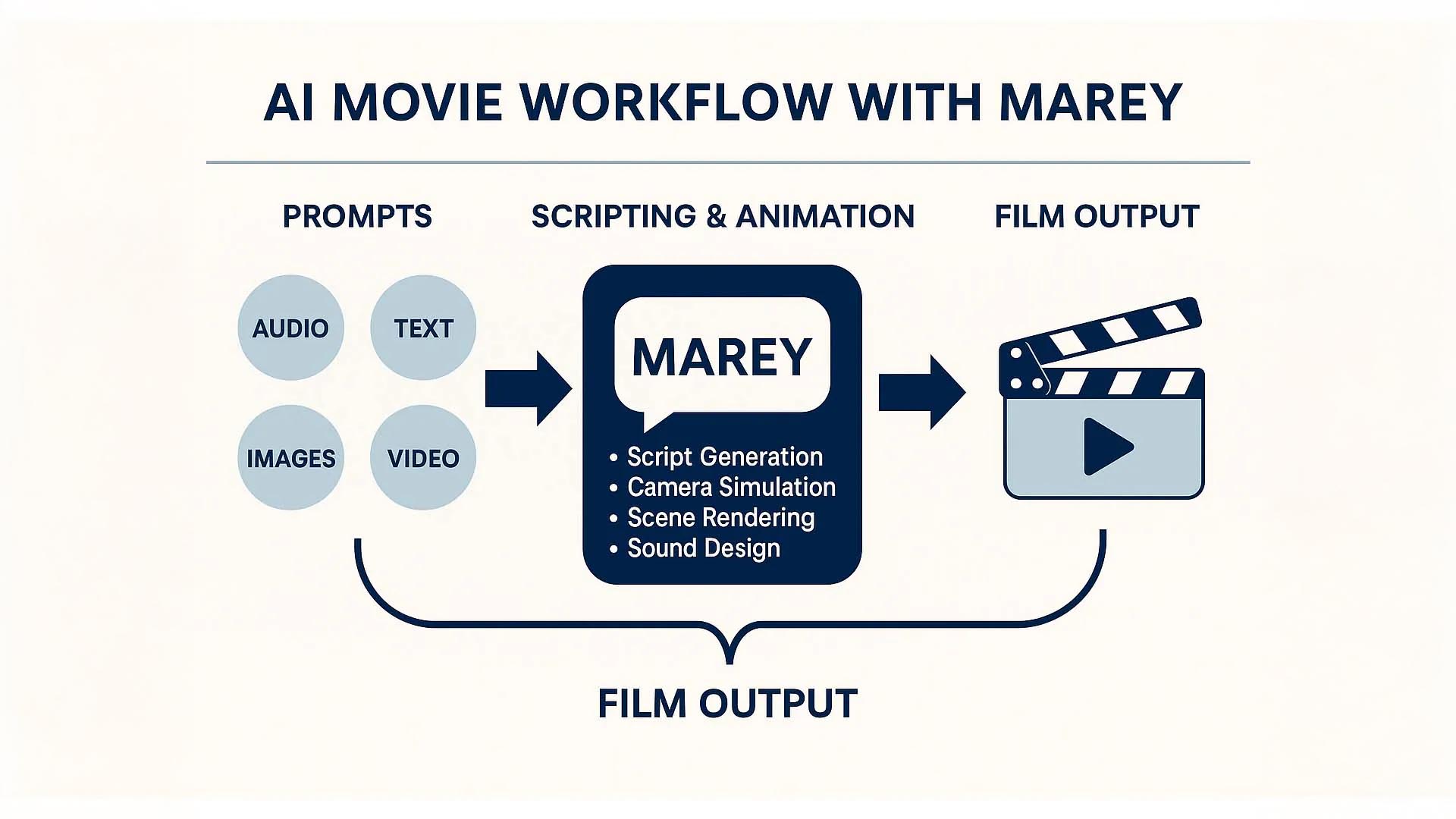

Infografik: Marey Workflow Overview

Die Visualisierung gibt einen strukturierten Überblick über den modularen Aufbau der Software Marey und ihren End-to-End-Prozess – von der initialen Eingabe bis zur fertigen Filmszene. Im Zentrum steht die Transformation von natürlichen Spracheingaben (Textprompts) in visuell und dramaturgisch kohärente Szenen mit Kamera, Bewegung, Licht und Ton.

Der Workflow beginnt mit der **semantischen Analyse des Prompts**: Die KI zerlegt die Eingabe in Handlungseinheiten, definiert Raumbezüge, erkennt Akteurslogiken und übersetzt dies in filmtypische Strukturen wie Shotgrößen, Perspektiven und Spannungsbögen.

Darauf folgt das **Shot-Design-Modul**, das Kameraachsen, Bildkomposition und Übergänge vorbereitet. Parallel werden **Bewegungspfad-Systeme** aktiviert – Nutzer können hier entweder durch Textstilmittel („Character walks slowly toward the door“) oder über eine visuelle Pfaddefinition explizit Einfluss auf Bewegungsverläufe nehmen. Diese Pfade dienen als Grundlage für die Motion Engine, welche realistische Bewegungsdynamik mit physikalischer Plausibilität erzeugt.

In den nächsten Schritten werden **visuelle Layer wie Lichtstimmung, Umgebungstextur und Stilparameter** angewendet, die sich an vorab definierten Style-Guides oder vom Prompt abgeleiteten Themen orientieren. Auch das **Soundmodul** ist integriert: Basierend auf Szene und dramaturgischer Entwicklung werden Musik, Umgebungsgeräusche und Dialoge generiert oder synthetisch platziert.

Infografik: Marey Workflow Overview

Visualisierung: Ulrich Buckenlei

Zum Abschluss erfolgt die **Komposition und Ausgabe** der Filmszene: Alle Komponenten – visuelle Frames, Audiospuren, Timinginformationen – werden zu einem einheitlichen, durchgängigen Ergebnis verbunden, das entweder als Preview oder als hochwertiger Export bereitgestellt wird.

Die Infografik zeigt zudem klar, an welchen Punkten kreative Kontrolle durch Nutzende möglich ist:

- Prompt Layer – Einflussnahme durch gezielte Formulierung und Strukturierung des Eingabetexts

- Parameterkontrolle – Feinjustierung von Stil, Tempo, Kameraführung und Emotionsprofilen

- Pfadsteuerung – Manuelle oder textbasierte Definition von Bewegungsverläufen im Raum

Diese modulare Struktur ermöglicht ein spannendes Zusammenspiel aus Automatisierung und Individualisierung. Marey übernimmt die operative Filmtechnik – die kreative Vision bleibt beim Menschen. Die Infografik macht deutlich: Wer die Sprache der Software versteht, kann mit wenigen Worten beeindruckend präzise Szenen entstehen lassen.

Beispielvideo: Cinematic Generation mit Marey

KI-generiertes Video via Marey, vertont von Ulrich Buckenlei

Das gezeigte Video zeigt eindrucksvoll, wie visuelle Kohärenz, Soundintegration und Schnitttempo automatisch durch Marey generiert werden. Das Ergebnis: ein Mini-Film von 90 Sekunden mit durchgehender Erzählspannung.

Marey demonstriert damit, wie weit Prompt-basierte Filmtechnologie heute bereits ist – und welche neuen Ausdrucksformen in naher Zukunft denkbar werden.

Sprechen Sie mit unseren Experten über Ihr Projekt

Sie arbeiten mit AI-generierter Videotechnologie, entwickeln immersive Contentformate oder experimentieren mit Prompt-basierten Produktionsmethoden? Dann besprechen Sie Ihre Ideen mit unserem Expertenteam. Gemeinsam identifizieren wir konkrete Anwendungsfelder, Designoptionen und technologische Synergien für Ihre Organisation.

Unsere Fachexperten aus den Bereichen AI, XR und 3D helfen Ihnen, das Potenzial von Tools wie Marey strategisch zu bewerten und praktisch zu nutzen.

- Strategie-Workshops – Zukunftspotenziale von AI-Generated Content verstehen

- Proof-of-Concept – Schnellstart in reale AI-Filmprojekte

- Technologieberatung – Auswahl, Training und Integration der richtigen Tools

Nehmen Sie jetzt Kontakt auf – und gestalten Sie mit uns das nächste Kapitel kreativer Produktion.

Kontaktieren Sie uns:

E-Mail: info@xrstager.com

Telefon: +49 89 21552678

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@xrstager.com

Nataliya Daniltseva (Projektleiterin)

Mobil: +49 176 72805705

E-Mail: nataliya.daniltseva@xrstager.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München